Частные уравнения множественной регрессии. Индексы множественной и частной корреляции и их расчет

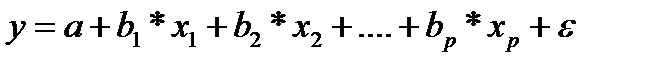

На основе линейного уравнения множественной регрессии

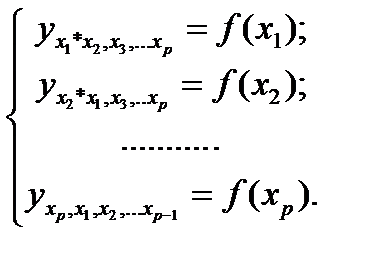

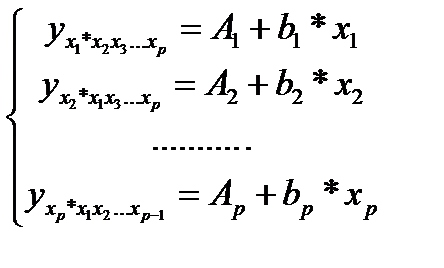

могут быть найдены частные уравнения регрессии:

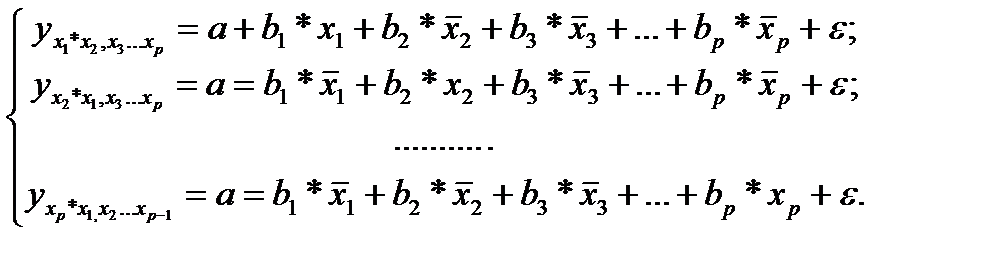

т.е. уравнения регрессии, которые связывают результативный признак с соответствующими факторами хi при закреплении других учитываемых во множественной регрессии факторов на среднем уровне. В случае линейной регрессии частные уравнения имеют следующий вид:

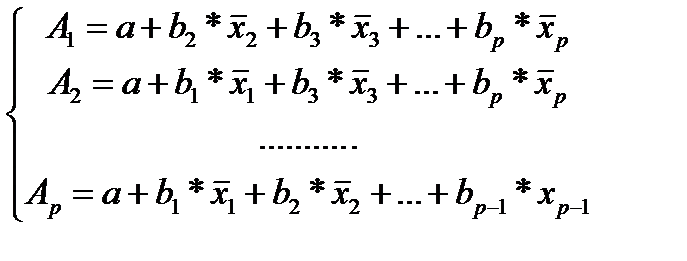

Подставляя в эти уравнения средние значения соответствующих факторов получаем систему уравнений линейной регрессии, т.е. имеем:

где

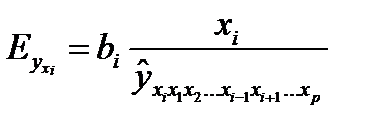

Частные уравнения регрессии характеризуют изолированное влияние фактора на результат, ибо другие факторы закреплены на низменном уровне. Эффекты влияния других факторов присоединены в них к свободному члену уравнения множественной регрессии (Аi).Это позволяет на основе частных уравнений регрессии определять частные коэффициенты эластичности

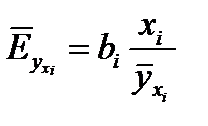

На основании данной информации могут быть найдены средние по совокупности показатели эластичности:

Практическая значимость уравнения множественной регрессии оценивается с помощью показателя множественной корреляции и его квадрата – коэффициента детерминации. Показатель множественной корреляции характеризует тесноту совместного влияния факторов на результат.

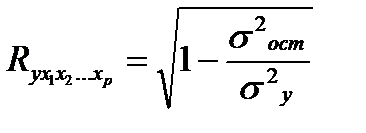

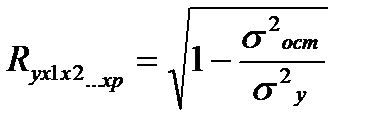

Независимо от вида уравнения индекс множественной корреляции рассчитывается по формуле:

где σ 2 y — общая дисперсия результативного признака,

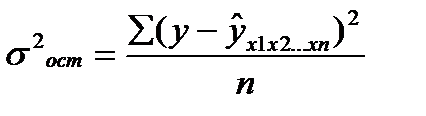

σ 2 ост — остаточная дисперсия .

Чем ближе его значение к 1, тем теснее связь результативного признака со всем набором исследуемых факторов.

Сравнивая индексы множественной регрессии и парной корреляции, можно сделать вывод о целесообразности включения в уравнение регрессии того или иного фактора. В частности, если дополнительно включенные в уравнение множественной регрессии факторы третьестепенны, то индекс множественной корреляции практически совпадает с индексом парной корреляции.

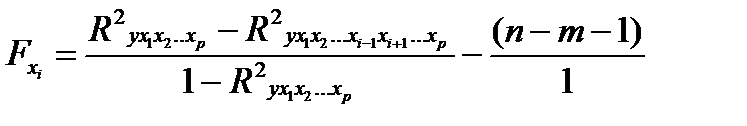

Если оценивается значимость влияния фактора хi в уравнении регрессии, то определяется частный F- критерий:

Значимость коэффициентов чистой регрессии производится по t — критерию Стьюдента.

24. Построение частных коэффициентов корреляции для модели множественной регрессии через показатель остаточной дисперсии

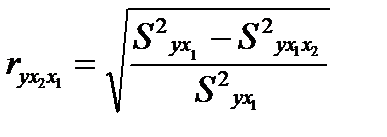

Частные коэффициенты (или индексы) корреляции характеризуют тесноту связи между результатом и соответствующим фактором при устранении влияния других факторов, включенных в уравнение регрессии.

Чем больше доля полученной разности в остаточной вариации, тем теснее связь между у и x2 , при неизменности действия фактора x1

Величина, рассчитываемая формулой:

называется индексом частной корреляции для фактора х2:

Аналогично определяется индекс частной корреляции для фактора x1.

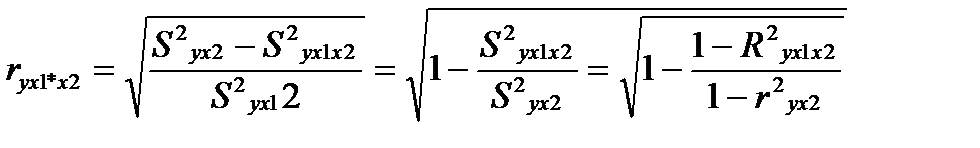

Выражая остаточную дисперсию через показатель детерминации

S 2 ост = σ 2 у (1-r 2 ), имеем формулу частной корреляции:

25. Коэффициент множественной корреляции

Практическая значимость уравнения множественной регрессии оценивается показателем множественной корреляции

Показатель множественной корреляции характеризует тесноту связи рассматриваемого набора факторов с исследуемым при знаком, или оценивает тесноту совместного влияния факторов на результат.

Независимо от формы связи показатель множественной корреляции можёт быть найден как индекс множественной корреляции:

σ 2 ост – остаточная дисперсия для уравнения у=f(x1,x2,… xр)

σ 2 у – общая дисперсия результативного признака

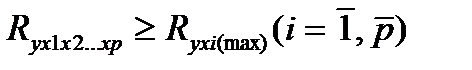

Методика построения индекса множественной корреляции аналогична построению индекса корреляции для парной зависимости. Его пределы от 0 до 1. Чем ближе его значение к 1, тем теснее связь результативного признака со всем I бором исследуемых факторов. Величина индекса множественно корреляции должна быть больше или равна максимальному парному индексу корреляции: —

Обоснованность включения факторов в регрессионный анализ приведет к существенному отличию показателя от индекса корреляции парной зависимости. При включении модель маловажных факторов происходит уравнение индекса множественной корреляции с индексом парной корреляции. Сравнивая индексы множественной и парной корреляции делают заключение о возможности включения в уравнение регрессии того или иного фактора.

Расчет индекса множественной Корреляции предполагает определение уравнения множественной регрессии и на его основе остаточной дисперсии:

Возможна и такая интерпретация формулы индекса множественной корреляции

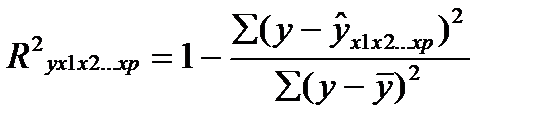

26. Коэффициент множественной детерминации

Коэффициент детерминации –это квадрат показателем множественной корреляции.

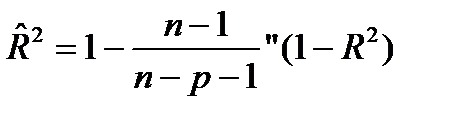

Множественный коэффициент детерминации можно рассматривать как меру качества уравнения регрессии, характеристику прогностической силы анализируемой регрессионной модели: чем ближе R 2 к единице, тем лучше регрессия описывает зависимость между объясняющими и зависимой переменными. Недостаток R 2 состоит в том, что его значение не убывает с ростом числа объясняющих переменных. В эконометрическом анализе чаще применяют скорректированный коэффициент детерминации R^ 2 определяемый по формуле

который может уменьшаться при введении в регрессионную модель переменных, не оказывающих существенного влияния на зависимую переменную.

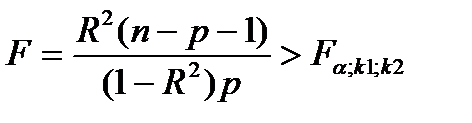

Если известен коэффициент детерминации R 2 то критерий значимости уравнения регрессии может быть записан в виде:

где ‚ к1= р, к2 = n — р — 1, ибо в уравнении множественной регрессии вместе со свободным членом оценивается m = р + 1 параметров.

27. Проверка гипотезы о значимости частного и множественного коэффициентов корреляции

Проверка гипотез используется, когда необходим обоснованный вывод о значимости частного и множественного коэффициентов корреляции. При этом гипотезой называется любое предположение о виде или параметрах неизвестного закона распределения.

Множественный коэффициент корреляции заключен в пре делах 0 до1. Он не меньше, чем абсолютная величина любого парного или частного коэффициента корреляции с таким же первичным индексом.

С помощью множественного коэффициента корреляции (по мере приближения к 1 делается вывод о тесноте взаимосвязи, но не о ее направлении.

Частный коэффициент корреляции. Если переменные коррелируют друг с другом, то на величине парного коэффициента корреляции частично сказывается влияние других переменных. В связи с этим часто возникает необходимость исследовать частную корреляцию между переменными при устранении влияния одной/нескольких переменных

28. Проверка гипотезы о значимости коэффициентов регрессии и модели множественной регрессии в целом

Основной предпосылкой регрессионного анализа является то, что только результативный признак (У) подчиняется нормальному закону распределения, а факторные признаки х 1 . Х 2 . х n могут иметь произвольный закон распределения. В анализе динамических рядов в качестве факторного признака выступает время t При этом в регрессионном анализе заранее подразумевается наличие причинно-следственных связей между результативным (У) и факторными х 1 . Х 2 . х n признаками. В тех случаях, когда из природы процессов в модели или из данных наблюдений над ней следует вывод о нормальном законе распределения двух СВ — Y и X , из которых одна является независимой, т. е. Y является функцией X , то возникает соблазн определить такую зависимость “формульно”, аналитически.Уравнение регрессии, или статистическая модель связи социально-экономических явлений, выражаемая функцией Y=f( х 1 . Х 2 . х n ) является достаточно адекватным реальному моделируемому явлению или процессу в случае соблюдения следующих требований их построения. 1) Совокупность исследуемых исходных данных должна быть однородной и математически описываться непрерывными функциями. 2) Возможность описания моделируемого явления одним или несколькими уравнениями причинно-следственных связей. 3) Все факторные признаки должны иметь количественное (цифровое) выражение. 4) Наличие достаточно большого объема исследуемой выборочной совокупности. 5) Причинно-следственные связи между явлениями и процессами следует описывать линейной или приводимой к линейной формой зависимости. 6) Отсутствие количественных ограничений на параметры модели связи. 7) Постоянство территориальной и временной структуры изучаемойсовокупности. Соблюдение данных требований позволяет исследователю построить статистическую модель связи, наилучшим образом аппроксимирующую моделируемые социально-экономические явления и процессы. В случае успеха нам будет намного проще вести моделирование. Конечно, наиболее заманчивой является перспектива линейной зависимости типа Y = a + b · X . Подобная задача носит название задачи регрессионного анализа и предполагает следующий способ решения. Выдвигается следующая гипотеза H 0 : случайная величина Y при фиксированном значении величины X распределена нормально с математическим ожиданием М y = a + b · X и дисперсией D y , не зависящей от X . При наличии результатов наблюдений над парами X i и Y i предварительно вычисляются средние значения M y и M x , а затем производится оценка коэффициента b в виде b = = R xy что следует из определениякоэффициента корреляции. После этого вычисляется оценка для a в виде <2 - 16>и производится проверка значимости полученных результатов. Таким образом, регрессионный анализ является мощным, хотя и далеко не всегда допустимым расширением корреляционного анализа, решая всё ту же задачу оценки связей в сложной системе.

29. Определение мультиколлинеарности. Последствия мулыиколлицеарности. Методы обнаружения мультиколлинеарности

Мультиколлинеарность -это процесс, при котором между факторами происходит совокупное воздействие друг на друга

Наличие мультиколлинеарности факторов может означать, что некоторые факторы действуют синхронно. В итоге вариация в исходных данных зависима и невозможно оценить воздействие каждого фактора в отдельности. Чем сильнее мультиколлинеарность факторов, тем менее надежна оценка распределения суммы объясненной вариации по отдельным факторам с помощью метода наименьших квадратов.

Если рассматривается регрессия у = а + b * х + с * z + d * v + ε то для расчета параметров с применением МНК предполагается равенство:

где

Если же факторы интеркоррелированы, то данное равенство нарушается.

Включение в модель мультиколлинеарных факторов нежелательно по причинам:

• затрудняется интерпретация параметров множественной регрессии как характеристик действия факторов в чистом виде, т.к. факторы коррелированны. При этом параметры линейной регрессии утрачивают экономический смысл;

• оценки параметров ненадежны, появляются стандартные ошибки, которые меняются с изменением объема наблюдений (по величине и знаку), Модель нельзя анализировать и строить на ее основе прогнозы.

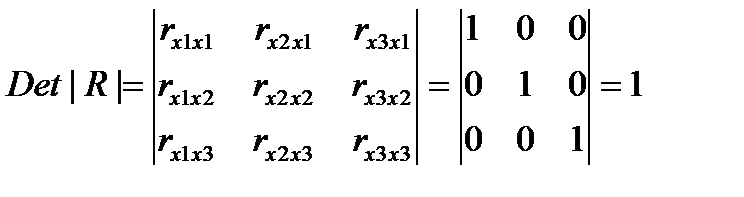

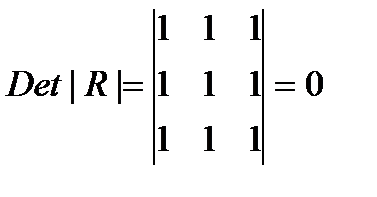

Для оценки мультиколлинеарности факторов может использоваться определитель матрицы парных Коэффициентов корреляции между факторами.

Если бы факторы не коррелировали между собой, то матрица парных коэффициентов корреляции между ними была бы единичной, т.к. все элементы не находящиеся на диагоналях равны 0. Для уравнения включающее три объясняющих переменных,

у = а + b1 * х1 + b2 * х2 + b3 * х3 +ε, при этом матрица коэффициентов корреляции между факторами имела определитель равный единице.

Если же между факторами существует полная линейная зависимость и все Коэффициенты корреляции равны единице, то определитель такой матрицы равен нулю.

Чем ближе к — нулю определитель матрицы межфакторной корреляции тем сильнее мультиколлинеарность факторов и ненадежнее результаты множествснной регрессии. Наоборот чем ближе к единице определитель матрицы межфакторной корреляции тем меньше мультиколлинеарность факторов.

30. Методы устранения мультиколлинеарности

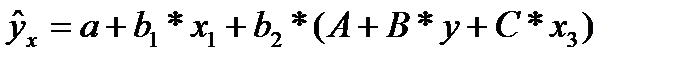

Устраняя мультиколлинеарность факторов чаще всего используют приведенную форму. Для этого в уравнение регрессии подставляют рассматриваемый фактор, выраженный из другого уравнения.

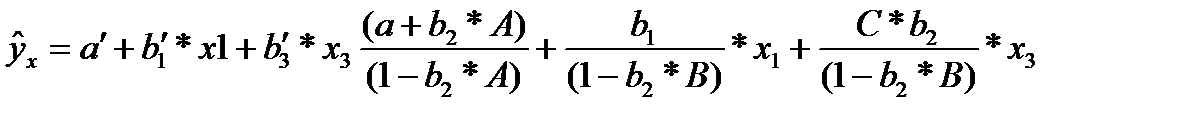

В двухфакторной регрессии вида

сделав предобразования получим:

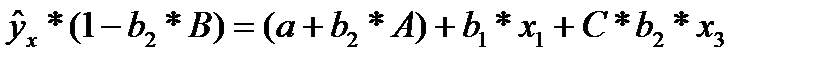

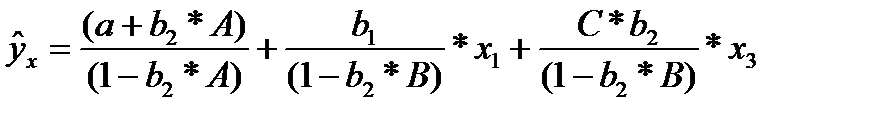

Если исключить один из факторов, то мы придем к уравнению парной регрессии. Вместе с тем, можно оставить факторы в модели, но исследовать данное двух факторное уравнение регрессии совместно с другим уравнением, в котором фактор рассматривается как зависимая переменная. При (1-b2*В) ≠ 0, делим первую и вторую части уравнения на (1-b2*В), получаем:

Получили приведенную форму уравнения для определения результативного признака у. Это уравнение может быть представлено в виде (32.4)

К нему для оценки параметров может быть применен метод наименьших квадратов.

Отбор факторов, включаемых в регрессию -основной этап практического использования методов регрессии. Подходы к отбору факторов на основе показателей корреляции могут различны. Они приводят построение уравнение множественной регрессии соответственно к разным методикам.

Наиболее распространены методы построения уравнения множественной регрессии:

• шаговый регрессионный анализ.

Каждый метод помогает устранить мультиколлинеарность позволяя производить отсев факторов из полного его набора (метод исключения), дополнительное введение фактора (метод включения), исключение ранее введенного фактора (шаговый регрессионный анализ).

На первый Взгляд может показаться, что матрица парных коэффициентов корреляции играет главную роль в отборе факторов. Вместе с тем вследствие взаимодействия факторов парные коэффициенты корреляции не могут полностью решать вопрос целесообразности включения в модель того определенного фактора. Эту роль выполняют показатели частной корреляции, оценивающие в чистом виде тесноту связи фактора с результатом. Матрица частных коэффициентов корреляции наиболее широко используется в процедуре отсева факторов. Отсев факторов можно проводить и по t-критерию Стьюдента для коэффициентов регрессии: из уравнения исключаются факторы с величиной t-критерия меньше табличного.

В заключении следует уточнить: число включаемых факторов обычно в 6—7 раз меньше объема совокупности, по которой строится регрессия. Если это соотношение нарушено, то число степеней свободы остаточной вариации очень мало. Это приводит к тому, что пара метры уравнения регрессии оказываются статистически незначимыми, а Р-критерий меньше табличного значения.

31. Модели регрессии, нелинейные по факторным переменным

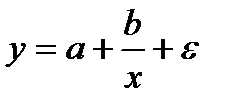

Если между экономическими явлениями существуют нелинейные соотношения, то они выражаются с помощью соответствующих нелинейных функций: например, равносторонней гиперболы

Различают два класса нелинейных регрессий:

• регрессии, нелинейные относительно включенных в анализ объясняющих переменных, но линейные по оцениваемым параметрам;

• регрессии, нелинейные по оцениваемым параметрам.

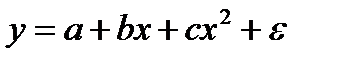

Примером нелинейной регрессии по включаемым в нее объясняющим переменным могут служить следующие функции:

• полиномы разных степеней

К нелинейным регрессиям по оцениваемым параметрам относятся функции:

Мультиколлинеарность

Последствия и признаки мультиколлинеарности

Если факторные переменные связаны строгой функциональной зависимостью, то говорят о полной мультиколлинеарности. В этом случае среди столбцов матрицы факторных переменных Х имеются линейно зависимые столбцы, и, по свойству определителей матрицы, det(X T X) = 0 , т. е. матрица (X T X) вырождена, а значит, не существует обратной матрицы. Матрица (X T X) -1 используется в построении МНК-оценок. Таким образом, полная мультиколлинеарность не позволяет однозначно оценить параметры исходной модели регрессии.

Признаки мультиколлинеарности

- Регрессионные коэффициенты значительно изменяются по мере удаления или добавления новых предикторов;

- Регрессионный коэффициент отрицательный, хотя, исходя из теории, значения зависимой переменной должны расти пропорционально изменению предиктора(или наоборот);

- Ни один из коэффициентов не обладает статистической значимостью, однако F-статистика показывает значимость коэффициента детерминации.

- Регрессионный коэффициент не является значимым, хотя теоретически связь между ним и зависимой переменной должна быть существенной.

- При изменении данных (увеличении или уменьшении выборки) оценки коэффициентов значительно изменяются

К каким трудностям приводит мультиколлинеарность факторов, включенных в модель, и как они могут быть разрешены?

Мультиколлинеарность может привести к нежелательным последствиям:

- оценки параметров становятся ненадежными. Они обнаруживают большие стандартные ошибки. С изменением объема наблюдений оценки меняются (не только по величине, но и по знаку), что делает модель непригодной для анализа и прогнозирования.

- затрудняется интерпретация параметров множественной регрессии как характеристик действия факторов в «чистом» виде, ибо факторы коррелированны; параметры линейной регрессии теряют экономический смысл;

- становится невозможным определить изолированное влияние факторов на результативный показатель.

Мультиколлинеарность повышает стандартную ошибку коэффициентов, тем самым искусственно снижая значимость.

Вид мультиколлинеарности, при котором факторные переменные связаны некоторой стохастической зависимостью, называется частичной. Если между факторными переменными имеется высокая степень корреляции, то матрица (X T X) близка к вырожденной, т. е. det(X T X) ≈ 0.

Матрица (X T X) -1 будет плохо обусловленной, что приводит к неустойчивости МНК-оценок. Частичная мультиколлинеарность приводит к следующим последствиям:

- увеличение дисперсий оценок параметров расширяет интервальные оценки и ухудшает их точность;

- уменьшение t-статистик коэффициентов приводит к неверным выводам о значимости факторов;

- неустойчивость МНК-оценок и их дисперсий.

Точных количественных критериев для обнаружения частичной мультиколлинеарности не существует. О наличии мультиколлинеарности может свидетельствовать близость к нулю определителя матрицы (X T X). Также исследуют значения парных коэффициентов корреляции. Если же определитель матрицы межфакторной корреляции близок к единице, то мультколлинеарности нет.

Существуют различные подходы преодоления сильной межфакторной корреляции. Простейший из них – исключение из модели фактора (или факторов), в наибольшей степени ответственных за мультиколлинеарность при условии, что качество модели при этом пострадает несущественно (а именно, теоретический коэффициент детерминации -R 2 y(x1. xm) снизится несущественно).

С помощью какой меры невозможно избавиться от мультиколлинеарности?

a) увеличение объема выборки;

b) исключения переменных высококоррелированных с остальными;

c) изменение спецификации модели;

d) преобразование случайной составляющей.

Парные (линейные) и частные коэффициенты корреляции

Парный коэффициент корреляции изменяется в пределах от –1 до +1. Чем ближе он по абсолютной величине к единице, тем ближе статистическая зависимость между x и y к линейной функциональной. Положительное значение коэффициента свидетельствует о том, что связь между признаками прямая (с ростом x увеличивается значение y ), отрицательное значение – связь обратная (с ростом x значение y уменьшается).

Можно дать следующую качественную интерпретацию возможных значений коэффициента корреляции: если |r| 0.7, то в данной модели множественной регрессии существует мультиколлинеарность.

Поскольку исходные данные, по которым устанавливается взаимосвязь признаков, являются выборкой из некой генеральной совокупности, вычисленные по этим данным коэффициенты корреляции будут выборочными, т. е. они лишь оценивают связь. Необходима проверка значимости, которая отвечает на вопрос: случайны или нет полученные результаты расчетов.

Значимость парных коэффициентов корреляции проверяют по t-критерию Стьюдента. Выдвигается гипотеза о равенстве нулю генерального коэффициента корреляции: H0: ρ = 0. Затем задаются параметры: уровень значимости α и число степеней свободы v = n-2. Используя эти параметры, по таблице критических точек распределения Стьюдента находят tкр, а по имеющимся данным вычисляют наблюдаемое значение критерия:

где r – парный коэффициент корреляции, рассчитанный по отобранным для исследования данным. Парный коэффициент корреляции считается значимым (гипотеза о равенстве коэффициента нулю отвергается) с доверительной вероятностью γ = 1- α, если tНабл по модулю будет больше, чем tкрит.

Если переменные коррелируют друг с другом, то на значении коэффициента корреляции частично сказывается влияние других переменных.

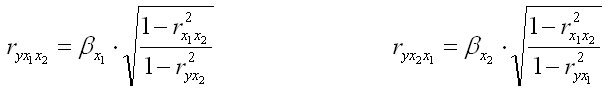

Частный коэффициент корреляции характеризует тесноту линейной зависимости между результатом и соответствующим фактором при устранении влияния других факторов. Частный коэффициент корреляции оценивает тесноту связи между двумя переменными при фиксированном значении остальных факторов. Если вычисляется, например, ryx1|x2 (частный коэффициент корреляции между y и x1 при фиксированном влиянии x2), это означает, что определяется количественная мера линейной зависимости между y и x1, которая будет иметь место, если устранить влияние x2 на эти признаки. Если исключают влияние только одного фактора, получают частный коэффициент корреляции первого порядка.

Сравнение значений парного и частного коэффициентов корреляции показывает направление воздействия фиксируемого фактора. Если частный коэффициент корреляции ryx1|x2 получится меньше, чем соответствующий парный коэффициент ryx1, значит, взаимосвязь признаков y и x1 в некоторой степени обусловлена воздействием на них фиксируемой переменной x2. И наоборот, большее значение частного коэффициента по сравнению с парным свидетельствует о том, что фиксируемая переменная x2 ослабляет своим воздействием связь y и x1.

Частный коэффициент корреляции между двумя переменными (y и x2) при исключении влияния одного фактора (x1) можно вычислить по следующей формуле:

Для других переменных формулы строятся аналогичным образом. При фиксированном x2

при фиксированном x3

Значимость частных коэффициентов корреляции проверяется аналогично случаю парных коэффициентов корреляции. Единственным отличием является число степеней свободы, которое следует брать равным v = n – l -2, где l – число фиксируемых факторов.

На основании частных коэффициентов можно сделать вывод об обоснованности включения переменных в регрессионную модель. Если значение коэффициента мало или он незначим, то это означает, что связь между данным фактором и результативной переменной либо очень слаба, либо вовсе отсутствует, поэтому фактор можно исключить из модели.

Пошаговая регрессия

На втором шаге строится уравнение регрессии с одной переменной, имеющей максимальный по абсолютной величине парный коэффициент корреляции с результативным признаком.

На третьем шаге в модель вводится новая переменная, имеющая наибольшее по абсолютной величине значение частного коэффициента корреляции с зависимой переменной при фиксированном влиянии ранее введенной переменной.

При введении в модель дополнительного фактора коэффициент детерминации должен возрастать, а остаточная дисперсия уменьшаться. Если этого не происходит, т. е. коэффициент множественной детерминации увеличивается незначительно, то ввод нового фактора признается нецелесообразным.

Пример №1 . По 20 предприятиям региона изучается зависимость выработки продукции на одного работника y (тыс. руб.) от удельного веса рабочих высокой квалификации в общей численности рабочих x1 (% от стоимости фондов на конец года) и от ввода в действие новых основных фондов x2 (%).

| Y | X1 | X2 |

| 6 | 10 | 3,5 |

| 6 | 12 | 3,6 |

| 7 | 15 | 3,9 |

| 7 | 17 | 4,1 |

| 7 | 18 | 4,2 |

| 8 | 19 | 4,5 |

| 8 | 19 | 5,3 |

| 9 | 20 | 5,3 |

| 9 | 20 | 5,6 |

| 10 | 21 | 6 |

| 10 | 21 | 6,3 |

| 11 | 22 | 6,4 |

| 11 | 23 | 7 |

| 12 | 25 | 7,5 |

| 12 | 28 | 7,9 |

| 13 | 30 | 8,2 |

| 13 | 31 | 8,4 |

| 14 | 31 | 8,6 |

| 14 | 35 | 9,5 |

| 15 | 36 | 10 |

Требуется:

- Построить корреляционное поле между выработкой продукции на одного работника и удельным весом рабочих высокой квалификации. Выдвинуть гипотезу о тесноте и виде зависимости между показателями X1 и Y .

- Оценить тесноту линейной связи между выработкой продукции на одного работника и удельным весом рабочих высокой квалификации с надежностью 0,9.

- Рассчитать коэффициенты линейного уравнения регрессии для зависимости выработки продукции на одного работника от удельного веса рабочих высокой квалификации.

- Проверить статистическую значимость параметров уравнения регрессии с надежностью 0,9 и построить для них доверительные интервалы.

- Рассчитать коэффициент детерминации. С помощью F -критерия Фишера оценить статистическую значимость уравнения регрессии с надежностью 0,9.

- Дать точечный и интервальный прогноз с надежностью 0,9 выработки продукции на одного работника для предприятия, на котором высокую квалификацию имеют 24% рабочих.

- Рассчитать коэффициенты линейного уравнения множественной регрессии и пояснить экономический смысл его параметров.

- Проанализировать статистическую значимость коэффициентов множественного уравнения с надежностью 0,9 и построить для них доверительные интервалы.

- Найти коэффициенты парной и частной корреляции. Проанализировать их.

- Найти скорректированный коэффициент множественной детерминации. Сравнить его с нескорректированным (общим) коэффициентом детерминации.

- С помощью F -критерия Фишера оценить адекватность уравнения регрессии с надежностью 0,9.

- Дать точечный и интервальный прогноз с надежностью 0,9 выработки продукции на одного работника для предприятия, на котором высокую квалификацию имеют 24% рабочих, а ввод в действие новых основных фондов составляет 5%.

- Проверить построенное уравнение на наличие мультиколлинеарности по: критерию Стьюдента; критерию χ2. Сравнить полученные результаты.

Решение проводим с помощью калькулятора. Далее приводится ход решения п.13.

Матрица парных коэффициентов корреляции R:

| — | y | x1 | x2 |

| y | 1 | 0.97 | 0.991 |

| x1 | 0.97 | 1 | 0.977 |

| x2 | 0.991 | 0.977 | 1 |

При наличии мультиколлинеарности определитель корреляционной матрицы близок к нулю. Для нашего примера: det = 0.00081158 , что свидетельствует о наличии сильной мультиколлинеарности.

Для отбора наиболее значимых факторов xi учитываются следующие условия:

— связь между результативным признаком и факторным должна быть выше межфакторной связи;

— связь между факторами должна быть не более 0.7. Если в матрице есть межфакторный коэффициент корреляции rxjxi > 0.7, то в данной модели множественной регрессии существует мультиколлинеарность.;

— при высокой межфакторной связи признака отбираются факторы с меньшим коэффициентом корреляции между ними.

В нашем случае rx1 x2 имеют |r|>0.7, что говорит о мультиколлинеарности факторов и о необходимости исключения одного из них из дальнейшего анализа.

Анализ первой строки этой матрицы позволяет произвести отбор факторных признаков, которые могут быть включены в модель множественной корреляционной зависимости. Факторные признаки, у которых |ryxi| 0.3 – связь практически отсутствует; 0.3 ≤ |r| ≤ 0.7 — связь средняя; 0.7 ≤ |r| ≤ 0.9 – связь сильная; |r| > 0.9 – связь весьма сильная.

Проверим значимость полученных парных коэффициентов корреляции с помощью t-критерия Стьюдента. Коэффициенты, для которых значения t-статистики по модулю больше найденного критического значения, считаются значимыми.

Рассчитаем наблюдаемые значения t-статистики для ryx1 по формуле:

где m = 1 — количество факторов в уравнении регрессии.

По таблице Стьюдента находим Tтабл

tкрит(n-m-1;α/2) = (18;0.025) = 2.101

Поскольку tнабл > tкрит, то отклоняем гипотезу о равенстве 0 коэффициента корреляции. Другими словами, коэффициент корреляции статистически — значим

Рассчитаем наблюдаемые значения t-статистики для ryx2 по формуле:

Поскольку tнабл > tкрит, то отклоняем гипотезу о равенстве 0 коэффициента корреляции. Другими словами, коэффициент корреляции статистически — значимю

Таким образом, связь между (y и xx1 ), (y и xx2 ) является существенной.

Наибольшее влияние на результативный признак оказывает фактор x2 (r = 0.99), значит, при построении модели он войдет в регрессионное уравнение первым.

Тестирование и устранение мультиколлинеарности.

Наиболее полным алгоритмом исследования мультиколлинеарности является алгоритм Фаррара-Глобера. С его помощью тестируют три вида мультиколлинеарности:

1. Всех факторов (χ 2 — хи-квадрат).

2. Каждого фактора с остальными (критерий Фишера).

3. Каждой пары факторов (критерий Стьюдента).

Проверим переменные на мультиколлинеарность методом Фаррара-Глоубера по первому виду статистических критериев (критерий «хи-квадрат»).

Формула для расчета значения статистики Фаррара-Глоубера:

χ 2 = -[n-1-(2m+5)/6]ln(det[R])

где m = 2 — количество факторов, n = 20 — количество наблюдений, det[R] — определитель матрицы парных коэффициентов корреляции R.

Сравниваем его с табличным значением при v = m/2(m-1) = 1 степенях свободы и уровне значимости α. Если χ 2 > χтабл 2 , то в векторе факторов есть присутствует мультиколлинеарность.

χтабл 2 (1;0.05) = 3.84146

Проверим переменные на мультиколлинеарность по второму виду статистических критериев (критерий Фишера).

Определяем обратную матрицу D = R -1 :

| D = |

|

Вычисляем F-критерии Фишера:

где dkk — диагональные элементы матрицы.

Рассчитанные значения критериев сравниваются с табличными при v1=n-m и v2=m-1 степенях свободы и уровне значимости α. Если Fk > FТабл, то k-я переменная мультиколлинеарна с другими.

v1=20-2 = 18; v2=2-1 = 1. FТабл(18;1) = 248

Поскольку F1 > Fтабл, то переменная y мультиколлинеарна с другими.

Поскольку F2 > Fтабл, то переменная x1 мультиколлинеарна с другими.

Поскольку F3 > Fтабл, то переменная x2 мультиколлинеарна с другими.

Проверим переменные на мультиколлинеарность по третьему виду статистических критериев (критерий Стьюдента). Для этого найдем частные коэффициенты корреляции.

Частные коэффициенты корреляции.

Коэффициент частной корреляции отличается от простого коэффициента линейной парной корреляции тем, что он измеряет парную корреляцию соответствующих признаков (y и xi) при условии, что влияние на них остальных факторов (xj) устранено.

На основании частных коэффициентов можно сделать вывод об обоснованности включения переменных в регрессионную модель. Если значение коэффициента мало или он незначим, то это означает, что связь между данным фактором и результативной переменной либо очень слаба, либо вовсе отсутствует, поэтому фактор можно исключить из модели.

Теснота связи низкая.

Определим значимость коэффициента корреляции ryx1 /x2 .

Для этого рассчитаем наблюдаемые значения t-статистики по формуле:

где k = 1 — число фиксируемых факторов.

По таблице Стьюдента находим Tтабл

tкрит(n-k-2;α/2) = (17;0.025) = 2.11

Поскольку tнабл tкрит, то отклоняем гипотезу о равенстве 0 коэффициента корреляции. Другими словами, коэффициент корреляции статистически — значим

Как видим, связь y и x2 при условии, что x1 войдет в модель, снизилась. Отсюда можно сделать вывод, что ввод в регрессионное уравнение x2 остается нецелесообразным.

Можно сделать вывод, что при построении регрессионного уравнения следует отобрать факторы x1 , x2.

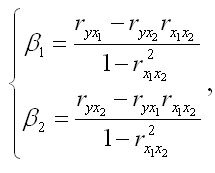

Частная корреляция

Ранжирование факторов в множественной линейной регрессии, может быть проведено через стандартизованные коэффициенты регрессии. Эту цель можно достигнуть с помощью частных коэффициентов корреляции для линейных связей. При нелинейной связи исследуемых признаков эту функцию выполняют частные индексы детерминации. Помимо этого, частные коэффициенты корреляции широко используют при решении проблемы отбора факторов: целесообразность включения фактора в модель может определяться величиной частных коэффициентов корреляции.

Частные коэффициенты корреляции характеризуют тесноту связи между результатом и фактором при устранении влияния другого фактора (или факторов), которые включенны в уравнение регрессии.

Показатели частной корреляции определяются как отношение сокращения остаточной дисперсии за счет дополнительного включения в анализ нового фактора к остаточной дисперсии, имевшей место до введения его в регрессионную модель.

Частные коэффициенты корреляции, рассчитанные по рекуррентной формуле могут находиться в пределах от -1 до +1, а по формулам через множественные коэффициенты детерминации — от 0 до 1. Сравнивая их друг с другом можно ранжировать факторы по тесноте их связи с результатом.

Частные коэффициенты на основе стандартизованных коэффициентов регрессии (бета-коэффициентов) дают меру тесноты связи каждого фактора с показателем (результатом) в чистом виде. Если из стандартизованного уравнения регрессии следует, что бета 1 > бета 2 > бета 3, т.е. по силе влияния факторов на результат их порядок таков: х1, х2, х3, такой же порядок факторов определяется и по соотношению частных коэффициентов корреляции.

Для уравнения регрессии в стандартизованном виде, коэффициенты могут быть определены по формулам, исходя из решения системы нормальных уравнений:

Источник: Эконометрика: Учебник / Под ред. И.И. Елисеевой. – М: Финансы и статистика, 2002. – 344 с.

http://math.semestr.ru/regress/multicollinearity.php

http://univer-nn.ru/ekonometrika/chastnaya-korrelyaciya/