Пример нахождения коэффициента детерминации

Коэффициент детерминации рассчитывается для оценки качества подбора уравнения регрессии. Для приемлемых моделей предполагается, что коэффициент детерминации должен быть хотя бы не меньше 50%. Модели с коэффициентом детерминации выше 80% можно признать достаточно хорошими. Значение коэффициента детерминации R 2 = 1 означает функциональную зависимость между переменными.

Для линейной зависимости коэффициент детерминации равен квадрату коэффициента корреляции rxy: R 2 = rxy 2 .

2 «>Рассчитать свое значение

Например, значение R 2 = 0.83, означает, что в 83% случаев изменения х приводят к изменению y . Другими словами, точность подбора уравнения регрессии — высокая.

В общем случае, коэффициент детерминации находится по формуле:

В этой формуле указаны дисперсии:

где ∑(y- y ) 2 — общая сумма квадратов отклонений;

В случае нелинейной регрессии коэффициент детерминации рассчитывается через этот калькулятор. При множественной регрессии, коэффициент детемрминации можно найти через сервис Множественная регрессия

Пример . Дано:

- доля денежных доходов, направленных на прирост сбережений во вкладах, займах, сертификатах и в покупку валюты, в общей сумме среднедушевого денежного дохода, % (Y)

- среднемесячная начисленная заработная плата, тыс. руб. (X)

Следует выполнить: 1. построить поле корреляции и сформировать гипотезу о возможной форме и направлении связи; 2. рассчитать параметры уравнений линейной и A1; 3. выполнить расчет прогнозного значения результата, предполагая, что прогнозные значения факторов составят B2 % от их среднего уровня; 4. оценить тесноту связи с помощью показателей корреляции и детерминации, проанализировать их значения; 5. Дать с помощью среднего (общего) коэффициента эластичности сравнительную оценку силы связи фактора с результатом; 6. Оценить с помощью средней ошибки аппроксимации качество уравнений; 7. Оценить надежность уравнений в целом через F-критерий Фишера для уровня значимости а = 0,05. По значениям характеристик, рассчитанных в пп. 5,6 и данном пункте, выберете лучшее уравнение регрессии и дайте его обоснование.

- Решение онлайн

- Видео решение

Уравнение имеет вид y = ax + b

1. Параметры уравнения регрессии.

Средние значения

Связь между признаком Y фактором X сильная и прямая.

Уравнение регрессии

Коэффициент детерминации для линейной регрессии равен квадрату коэффициента корреляции.

R 2 = 0.91 2 = 0.83, т.е. в 83% случаев изменения х приводят к изменению y. Другими словами — точность подбора уравнения регрессии — высокая

| x | y | x 2 | y 2 | x ∙ y | y(x) | (y-y cp ) 2 | (y-y(x)) 2 | (x-x p ) 2 |

| 15.1 | 255 | 228.01 | 65025 | 3850.5 | 505.26 | 527451.17 | 62630.22 | 420.25 |

| 17 | 261 | 289 | 68121 | 4437 | 549.38 | 518772.07 | 83161.41 | 345.96 |

| 12 | 293 | 144 | 85849 | 3516 | 433.28 | 473699.53 | 19678.51 | 556.96 |

| 10 | 310 | 100 | 96100 | 3100 | 386.84 | 450587.75 | 5904.58 | 655.36 |

| 74 | 1425 | 5476 | 2030625 | 105450 | 1872.88 | 196906.67 | 200600 | 1474.56 |

| 83 | 1985 | 6889 | 3940225 | 164755 | 2081.86 | 1007497.33 | 9381.6 | 2246.76 |

| 85 | 2549 | 7225 | 6497401 | 216665 | 2128.3 | 2457813.93 | 176990.6 | 2440.36 |

| 81 | 2012 | 6561 | 4048144 | 162972 | 2035.42 | 1062428.38 | 548.49 | 2061.16 |

| 22 | 1562 | 484 | 2439844 | 34364 | 665.47 | 337260.88 | 803758.38 | 184.96 |

| 10 | 386 | 100 | 148996 | 3860 | 386.84 | 354332.48 | 0.71 | 655.36 |

| 4 | 383 | 16 | 146689 | 1532 | 247.52 | 357913.03 | 18353.53 | 998.56 |

| 14.1 | 354.1 | 198.81 | 125386.81 | 4992.81 | 482.04 | 393327.58 | 16368.87 | 462.25 |

| 427.2 | 11775.1 | 27710.82 | 19692405.81 | 709494.31 | 11775.1 | 8137990.81 | 1397376.9 | 12502.5 |

Значимость коэффициента корреляции

По таблице Стьюдента находим Tтабл

Tтабл (n-m-1;a) = (10;0.05) = 1.812

Поскольку Tнабл > Tтабл , то отклоняем гипотезу о равенстве 0 коэффициента корреляции. Другими словами, коэффициента корреляции статистически — значим

Анализ точности определения оценок коэффициентов регрессии

S a = 3.3432

Доверительные интервалы для зависимой переменной

Рассчитаем границы интервала, в котором будет сосредоточено 95% возможных значений Y при неограниченно большом числе наблюдений и X = 1

(-557.64;913.38)

Проверка гипотез относительно коэффициентов линейного уравнения регрессии

1) t-статистика

Статистическая значимость коэффициента регрессии a подтверждается (6.95>1.812).

Статистическая значимость коэффициента регрессии b не подтверждается (0.96 Fkp, то коэффициент детерминации статистически значим

Коэффициент детерминации: формулы, расчет, интерпретация, примеры

Коэффициент детерминации: формулы, расчет, интерпретация, примеры — Наука

Содержание:

В коэффициент детерминации — число от 0 до 1, которое представляет долю точек (X, Y), которые следуют за линией регрессии соответствия набора данных с двумя переменными.

Он также известен как степень соответствия и обозначается R 2 . Для его вычисления берется частное между дисперсией данных Ŷi, оцененных с помощью регрессионной модели, и дисперсией данных Yi, соответствующих каждому Xi данных.

Если 100% данных находятся на линии функции регрессии, то коэффициент детерминации будет равен 1.

Напротив, если для набора данных и некоторой функции настройки коэффициент R 2 оказывается равным 0,5, то можно сказать, что посадка на 50% удовлетворительна или хороша.

Аналогично, когда регрессионная модель возвращает значения R 2 ниже 0,5, это означает, что выбранная функция настройки не адаптируется удовлетворительно к данным, поэтому необходимо искать другую функцию настройки.

И когда ковариация или коэффициент корреляции стремится к нулю, то переменные X и Y в данных не связаны, и поэтому R 2 он также будет стремиться к нулю.

Как рассчитать коэффициент детерминации?

В предыдущем разделе было сказано, что коэффициент детерминации рассчитывается путем нахождения частного между дисперсиями:

-Оценено функцией регрессии переменной Y

-То переменной Yi, соответствующей каждой переменной Xi из N пар данных.

Математически это выглядит так:

Из этой формулы следует, что R 2 представляет собой долю дисперсии, объясняемую регрессионной моделью. В качестве альтернативы R можно рассчитать 2 используя следующую формулу, полностью эквивалентную предыдущей:

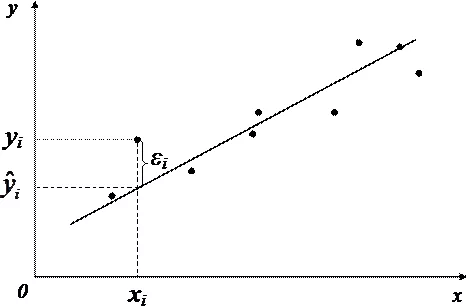

Где Sε представляет собой дисперсию остатков εi = Ŷi — Yi, а Sy представляет собой дисперсию набора значений Yi данных. Для определения Ŷi применяется функция регрессии, что означает утверждение, что Ŷi = f (Xi).

Дисперсия набора данных Yi, где i от 1 до N, рассчитывается следующим образом:

Sy = [Σ (Yi — ) 2 ) / (N-1)]

А затем поступаем аналогичным образом для Sŷ или для Sε.

Иллюстративный случай

Чтобы показать детали того, как расчет коэффициент детерминации Мы возьмем следующий набор из четырех пар данных:

Для этого набора данных предлагается линейная регрессия, полученная с помощью метода наименьших квадратов:

Применяя эту функцию регулировки, крутящие моменты получаются:

Затем мы вычисляем среднее арифметическое для X и Y:

= (1 + 2 + 3 + 4) / 4 = 2.5

= (1 + 3 + 6 + 7) / 4 = 4.25

Дисперсия Sy

Sy = [(1–4,25) 2 + (3 – 4.25) 2 + (6 – 4.25) 2 +…. ….(7 – 4.25) 2 ] / (4-1)=

= [(-3.25) 2 + (-1.25) 2 + (1.75) 2 + (2.75) 2 ) / (3)] = 7.583

Дисперсия Sŷ

Sŷ = [(1,1 — 4,25) 2 + (3.2 – 4.25) 2 + (5.3 – 4.25) 2 +…. ….(7.4 – 4.25) 2 ] / (4-1)=

= [(-3.25) 2 + (-1.25) 2 + (1.75) 2 + (2.75) 2 ) / (3)] = 7.35

Коэффициент детерминации R 2

р 2 = Sŷ / Sy = 7,35 / 7,58 = 0,97

Интерпретация

Коэффициент детерминации для иллюстративного случая, рассмотренного в предыдущем сегменте, оказался равным 0,98. Другими словами, линейная регулировка через функцию:

Он на 98% надежен в объяснении данных, с которыми он был получен с использованием метода наименьших квадратов.

Помимо коэффициента детерминации, есть коэффициент линейной корреляции или также известный как коэффициент Пирсона. Этот коэффициент, обозначаемый какр, рассчитывается по следующей зависимости:

Здесь числитель представляет собой ковариацию между переменными X и Y, а знаменатель — это произведение стандартного отклонения для переменной X и стандартного отклонения для переменной Y.

Коэффициент Пирсона может принимать значения от -1 до +1. Когда этот коэффициент стремится к +1, существует прямая линейная корреляция между X и Y. Если вместо этого он стремится к -1, существует линейная корреляция, но когда X увеличивается, Y уменьшается. Наконец, он близок к нулю, между двумя переменными нет корреляции.

Следует отметить, что коэффициент детерминации совпадает с квадратом коэффициента Пирсона, только если первый был рассчитан на основе линейной аппроксимации, но это равенство не действует для других нелинейных аппроксимаций.

Примеры

— Пример 1

Группа старшеклассников решила определить эмпирический закон для периода маятника в зависимости от его длины. Для достижения этой цели они проводят серию измерений, в которых измеряют время колебания маятника на разной длине, получая следующие значения:

| Длина (м) | Период (ы) |

|---|---|

| 0,1 | 0,6 |

| 0,4 | 1,31 |

| 0,7 | 1,78 |

| 1 | 1,93 |

| 1,3 | 2,19 |

| 1,6 | 2,66 |

| 1,9 | 2,77 |

| 3 | 3,62 |

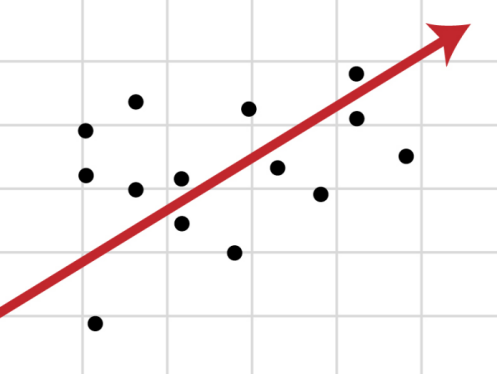

Требуется построить диаграмму рассеяния данных и выполнить линейную аппроксимацию через регрессию. Также покажите уравнение регрессии и его коэффициент детерминации.

Решение

Наблюдается довольно высокий коэффициент детерминации (95%), поэтому можно подумать, что линейная аппроксимация является оптимальной. Однако, если рассматривать точки вместе, оказывается, что они имеют тенденцию изгибаться вниз. Эта деталь не рассматривается в линейной модели.

— Пример 2

Для тех же данных в Примере 1 сделайте диаграмму рассеяния данных.В этом случае, в отличие от примера 1, требуется корректировка регрессии с использованием потенциальной функции.

Также покажите функцию подгонки и ее коэффициент детерминации R 2 .

Решение

Потенциальная функция имеет вид f (x) = Ax B , где A и B — константы, определяемые методом наименьших квадратов.

На предыдущем рисунке показана потенциальная функция и ее параметры, а также коэффициент детерминации с очень высоким значением 99%. Обратите внимание на то, что данные соответствуют кривизне линии тренда.

— Пример 3

Используя те же данные из примера 1 и примера 2, выполните полиномиальную аппроксимацию второй степени. Показать график, подобрать полином и коэффициент детерминации R 2 корреспондент.

Решение

При подборе полинома второй степени вы можете увидеть линию тренда, которая хорошо соответствует кривизне данных. Кроме того, коэффициент детерминации выше линейного соответствия и ниже потенциального соответствия.

Сравнение пригодности

Из трех показанных подгонок тот, у которого самый высокий коэффициент детерминации, является потенциальным подгонкой (пример 2).

Подгонка потенциала совпадает с физической теорией маятника, которая, как известно, устанавливает, что период маятника пропорционален квадратному корню из его длины, а коэффициент пропорциональности равен 2π / √g, где g — ускорение свободного падения.

Этот тип потенциального соответствия не только имеет самый высокий коэффициент детерминации, но и показатель степени и константа пропорциональности соответствуют физической модели.

Выводы

— Регулировка регрессии определяет параметры функции, которая направлена на объяснение данных с использованием метода наименьших квадратов. Этот метод состоит в минимизации суммы квадратов разницы между значением Y настройки и значением Yi данных для значений Xi данных. Это определяет параметры функции настройки.

-Как мы видели, наиболее распространенной функцией настройки является линия, но она не единственная, поскольку настройки также могут быть полиномиальными, потенциальными, экспоненциальными, логарифмическими и другими.

-В любом случае коэффициент детерминации зависит от данных и типа корректировки и является показателем качества примененной корректировки.

-Наконец, коэффициент детерминации указывает процент общей изменчивости между значением Y данных по отношению к значению соответствия для данного X.

R — значит регрессия

Статистика в последнее время получила мощную PR поддержку со стороны более новых и шумных дисциплин — Машинного Обучения и Больших Данных. Тем, кто стремится оседлать эту волну необходимо подружится с уравнениями регрессии. Желательно при этом не только усвоить 2-3 приемчика и сдать экзамен, а уметь решать проблемы из повседневной жизни: найти зависимость между переменными, а в идеале — уметь отличить сигнал от шума.

Для этой цели мы будем использовать язык программирования и среду разработки R, который как нельзя лучше приспособлен к таким задачам. Заодно, проверим от чего зависят рейтинг Хабрапоста на статистике собственных статей.

Введение в регрессионный анализ

Если имеется корреляционная зависимость между переменными y и x , возникает необходимость определить функциональную связь между двумя величинами. Зависимость среднего значения

называется регрессией y по x .

Основу регрессионного анализа составляет метод наименьших квадратов (МНК), в соответствии с которым в качестве уравнения регресии берется функция такая, что сумма квадратов разностей

минимальна.

Карл Гаусс открыл, или точнее воссоздал, МНК в возрасте 18 лет, однако впервые результаты были опубликованы Лежандром в 1805 г. По непроверенным данным метод был известен еще в древнем Китае, откуда он перекочевал в Японию и только затем попал в Европу. Европейцы не стали делать из этого секрета и успешно запустили в производство, обнаружив с его помощью траекторию карликовой планеты Церес в 1801 г.

Вид функции , как правило, определен заранее, а с помощью МНК подбираются оптимальные значения неизвестных параметров. Метрикой рассеяния значений

вокруг регрессии

является дисперсия.

- k — число коэффициентов в системе уравнений регрессии.

Чаще всего используется модель линейной регрессии, а все нелинейные зависимости приводят к линейному виду с помощью алгебраических ухищрений, различных преобразования переменных y и x .

Линейная регрессия

Уравнения линейной регрессии можно записать в виде

В матричном виде это выгладит

- y — зависимая переменная;

- x — независимая переменная;

- β — коэффициенты, которые необходимо найти с помощью МНК;

- ε — погрешность, необъяснимая ошибка и отклонение от линейной зависимости;

Случайная величина может быть интерпретирована как сумма из двух слагаемых:

— полная дисперсия (TSS).

— объясненная часть дисперсии (ESS).

— остаточная часть дисперсии (RSS).

Еще одно ключевое понятие — коэффициент корреляции R 2 .

Ограничения линейной регрессии

Для того, чтобы использовать модель линейной регрессии необходимы некоторые допущения относительно распределения и свойств переменных.

- Линейность, собственно. Увеличение, или уменьшение вектора независимых переменных в k раз, приводит к изменению зависимой переменной также в k раз.

- Матрица коэффициентов обладает полным рангом, то есть векторы независимых переменных линейно независимы.

- Экзогенность независимых переменных —

. Это требование означает, что математическое ожидание погрешности никоим образом нельзя объяснить с помощью независимых переменных.

- Однородность дисперсии и отсутствие автокорреляции. Каждая εi обладает одинаковой и конечной дисперсией σ 2 и не коррелирует с другой εi. Это ощутимо ограничивает применимость модели линейной регрессии, необходимо удостовериться в том, что условия соблюдены, иначе обнаруженная взаимосвязь переменных будет неверно интерпретирована.

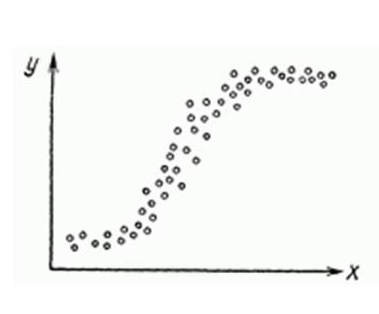

Как обнаружить, что перечисленные выше условия не соблюдены? Ну, во первых довольно часто это видно невооруженным глазом на графике.

Неоднородность дисперсии

При возрастании дисперсии с ростом независимой переменной имеем график в форме воронки.

Нелинейную регрессии в некоторых случая также модно увидеть на графике довольно наглядно.

Тем не менее есть и вполне строгие формальные способы определить соблюдены ли условия линейной регрессии, или нарушены.

- Автокорреляция проверяется статистикой Дарбина-Уотсона (0 ≤ d ≤ 4). Если автокорреляции нет, то значения критерия d≈2, при позитивной автокорреляции d≈0, при отрицательной — d≈4.

- Неоднородность дисперсии — Тест Уайта,

, при

\chi<^2>_<\alpha;m-1>$» data-tex=»inline»/> нулевая гипотеза отвергается и констатируется наличие неоднородной дисперсии. Используя ту же

можно еще применить тест Бройша-Пагана.

- Мультиколлинеарность — нарушения условия об отсутствии взаимной линейной зависимости между независимыми переменными. Для проверки часто используют VIF-ы (Variance Inflation Factor).

В этой формуле — коэффициент взаимной детерминации между

и остальными факторами. Если хотя бы один из VIF-ов > 10, вполне резонно предположить наличие мультиколлинеарности.

Почему нам так важно соблюдение всех выше перечисленных условий? Все дело в Теореме Гаусса-Маркова, согласно которой оценка МНК является точной и эффективной лишь при соблюдении этих ограничений.

Как преодолеть эти ограничения

Нарушения одной или нескольких ограничений еще не приговор.

- Нелинейность регрессии может быть преодолена преобразованием переменных, например через функцию натурального логарифма ln .

- Таким же способом возможно решить проблему неоднородной дисперсии, с помощью ln , или sqrt преобразований зависимой переменной, либо же используя взвешенный МНК.

- Для устранения проблемы мультиколлинеарности применяется метод исключения переменных. Суть его в том, что высоко коррелированные объясняющие переменные устраняются из регрессии, и она заново оценивается. Критерием отбора переменных, подлежащих исключению, является коэффициент корреляции. Есть еще один способ решения данной проблемы, который заключается в замене переменных, которым присуща мультиколлинеарность, их линейной комбинацией. Этим весь список не исчерпывается, есть еще пошаговая регрессия и другие методы.

К сожалению, не все нарушения условий и дефекты линейной регрессии можно устранить с помощью натурального логарифма. Если имеет место автокорреляция возмущений к примеру, то лучше отступить на шаг назад и построить новую и лучшую модель.

Линейная регрессия плюсов на Хабре

Итак, довольно теоретического багажа и можно строить саму модель.

Мне давно было любопытно от чего зависит та самая зелененькая цифра, что указывает на рейтинг поста на Хабре. Собрав всю доступную статистику собственных постов, я решил прогнать ее через модель линейно регрессии.

Загружает данные из tsv файла.

- points — Рейтинг статьи

- reads — Число просмотров.

- comm — Число комментариев.

- faves — Добавлено в закладки.

- fb — Поделились в социальных сетях (fb + vk).

- bytes — Длина в байтах.

Вопреки моим ожиданиям наибольшая отдача не от количества просмотров статьи, а от комментариев и публикаций в социальных сетях. Я также полагал, что число просмотров и комментариев будет иметь более сильную корреляцию, однако зависимость вполне умеренная — нет надобности исключать ни одну из независимых переменных.

Теперь собственно сама модель, используем функцию lm .

В первой строке мы задаем параметры линейной регрессии. Строка points

. определяет зависимую переменную points и все остальные переменные в качестве регрессоров. Можно определить одну единственную независимую переменную через points

reads , набор переменных — points

Перейдем теперь к расшифровке полученных результатов.

- Intercept — Если у нас модель представлена в виде

, то тогда

— точка пересечения прямой с осью координат, или intercept .

- R-squared — Коэффициент детерминации указывает насколько тесной является связь между факторами регрессии и зависимой переменной, это соотношение объясненных сумм квадратов возмущений, к необъясненным. Чем ближе к 1, тем ярче выражена зависимость.

- Adjusted R-squared — Проблема с

в том, что он по любому растет с числом факторов, поэтому высокое значение данного коэффициента может быть обманчивым, когда в модели присутствует множество факторов. Для того, чтобы изъять из коэффициента корреляции данное свойство был придуман скорректированный коэффициент детерминации .

- F-statistic — Используется для оценки значимости модели регрессии в целом, является соотношением объяснимой дисперсии, к необъяснимой. Если модель линейной регрессии построена удачно, то она объясняет значительную часть дисперсии, оставляя в знаменателе малую часть. Чем больше значение параметра — тем лучше.

- t value — Критерий, основанный на t распределении Стьюдента . Значение параметра в линейной регрессии указывает на значимость фактора, принято считать, что при t > 2 фактор является значимым для модели.

- p value — Это вероятность истинности нуль гипотезы, которая гласит, что независимые переменные не объясняют динамику зависимой переменной. Если значение p value ниже порогового уровня (.05 или .01 для самых взыскательных), то нуль гипотеза ложная. Чем ниже — тем лучше.

Можно попытаться несколько улучшить модель, сглаживая нелинейные факторы: комментарии и посты в социальных сетях. Заменим значения переменных fb и comm их степенями.

Проверим значения параметров линейной регрессии.

Как видим в целом отзывчивость модели возросла, параметры подтянулись и стали более шелковистыми , F-статистика выросла, так же как и скорректированный коэффициент детерминации .

Проверим, соблюдены ли условия применимости модели линейной регрессии? Тест Дарбина-Уотсона проверяет наличие автокорреляции возмущений.

И напоследок проверка неоднородности дисперсии с помощью теста Бройша-Пагана.

В заключение

Конечно наша модель линейной регрессии рейтинга Хабра-топиков получилось не самой удачной. Нам удалось объяснить не более, чем половину вариативности данных. Факторы надо чинить, чтобы избавляться от неоднородной дисперсии, с автокорреляцией тоже непонятно. Вообще данных маловато для сколь-нибудь серьезной оценки.

Но с другой стороны, это и хорошо. Иначе любой наспех написанный тролль-пост на Хабре автоматически набирал бы высокий рейтинг, а это к счастью не так.

http://ru1.warbletoncouncil.org/coeficiente-de-determinacion-11466

http://habr.com/ru/post/350668/