R — значит регрессия

Статистика в последнее время получила мощную PR поддержку со стороны более новых и шумных дисциплин — Машинного Обучения и Больших Данных. Тем, кто стремится оседлать эту волну необходимо подружится с уравнениями регрессии. Желательно при этом не только усвоить 2-3 приемчика и сдать экзамен, а уметь решать проблемы из повседневной жизни: найти зависимость между переменными, а в идеале — уметь отличить сигнал от шума.

Для этой цели мы будем использовать язык программирования и среду разработки R, который как нельзя лучше приспособлен к таким задачам. Заодно, проверим от чего зависят рейтинг Хабрапоста на статистике собственных статей.

Введение в регрессионный анализ

Если имеется корреляционная зависимость между переменными y и x , возникает необходимость определить функциональную связь между двумя величинами. Зависимость среднего значения

называется регрессией y по x .

Основу регрессионного анализа составляет метод наименьших квадратов (МНК), в соответствии с которым в качестве уравнения регресии берется функция такая, что сумма квадратов разностей

минимальна.

Карл Гаусс открыл, или точнее воссоздал, МНК в возрасте 18 лет, однако впервые результаты были опубликованы Лежандром в 1805 г. По непроверенным данным метод был известен еще в древнем Китае, откуда он перекочевал в Японию и только затем попал в Европу. Европейцы не стали делать из этого секрета и успешно запустили в производство, обнаружив с его помощью траекторию карликовой планеты Церес в 1801 г.

Вид функции , как правило, определен заранее, а с помощью МНК подбираются оптимальные значения неизвестных параметров. Метрикой рассеяния значений

вокруг регрессии

является дисперсия.

- k — число коэффициентов в системе уравнений регрессии.

Чаще всего используется модель линейной регрессии, а все нелинейные зависимости приводят к линейному виду с помощью алгебраических ухищрений, различных преобразования переменных y и x .

Линейная регрессия

Уравнения линейной регрессии можно записать в виде

В матричном виде это выгладит

- y — зависимая переменная;

- x — независимая переменная;

- β — коэффициенты, которые необходимо найти с помощью МНК;

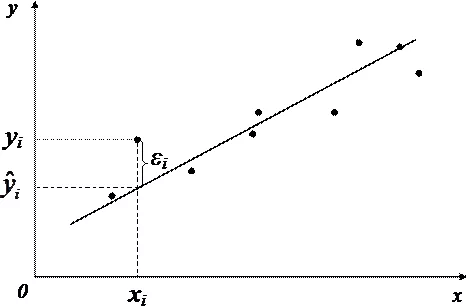

- ε — погрешность, необъяснимая ошибка и отклонение от линейной зависимости;

Случайная величина может быть интерпретирована как сумма из двух слагаемых:

— полная дисперсия (TSS).

— объясненная часть дисперсии (ESS).

— остаточная часть дисперсии (RSS).

Еще одно ключевое понятие — коэффициент корреляции R 2 .

Ограничения линейной регрессии

Для того, чтобы использовать модель линейной регрессии необходимы некоторые допущения относительно распределения и свойств переменных.

- Линейность, собственно. Увеличение, или уменьшение вектора независимых переменных в k раз, приводит к изменению зависимой переменной также в k раз.

- Матрица коэффициентов обладает полным рангом, то есть векторы независимых переменных линейно независимы.

- Экзогенность независимых переменных —

. Это требование означает, что математическое ожидание погрешности никоим образом нельзя объяснить с помощью независимых переменных.

- Однородность дисперсии и отсутствие автокорреляции. Каждая εi обладает одинаковой и конечной дисперсией σ 2 и не коррелирует с другой εi. Это ощутимо ограничивает применимость модели линейной регрессии, необходимо удостовериться в том, что условия соблюдены, иначе обнаруженная взаимосвязь переменных будет неверно интерпретирована.

Как обнаружить, что перечисленные выше условия не соблюдены? Ну, во первых довольно часто это видно невооруженным глазом на графике.

Неоднородность дисперсии

При возрастании дисперсии с ростом независимой переменной имеем график в форме воронки.

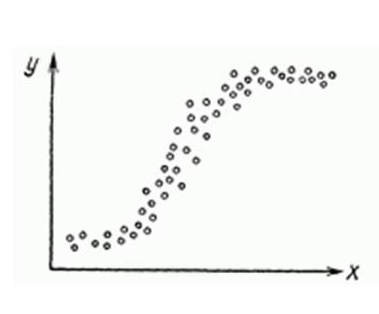

Нелинейную регрессии в некоторых случая также модно увидеть на графике довольно наглядно.

Тем не менее есть и вполне строгие формальные способы определить соблюдены ли условия линейной регрессии, или нарушены.

- Автокорреляция проверяется статистикой Дарбина-Уотсона (0 ≤ d ≤ 4). Если автокорреляции нет, то значения критерия d≈2, при позитивной автокорреляции d≈0, при отрицательной — d≈4.

- Неоднородность дисперсии — Тест Уайта,

, при

\chi<^2>_<\alpha;m-1>$» data-tex=»inline»/> нулевая гипотеза отвергается и констатируется наличие неоднородной дисперсии. Используя ту же

можно еще применить тест Бройша-Пагана.

- Мультиколлинеарность — нарушения условия об отсутствии взаимной линейной зависимости между независимыми переменными. Для проверки часто используют VIF-ы (Variance Inflation Factor).

В этой формуле — коэффициент взаимной детерминации между

и остальными факторами. Если хотя бы один из VIF-ов > 10, вполне резонно предположить наличие мультиколлинеарности.

Почему нам так важно соблюдение всех выше перечисленных условий? Все дело в Теореме Гаусса-Маркова, согласно которой оценка МНК является точной и эффективной лишь при соблюдении этих ограничений.

Как преодолеть эти ограничения

Нарушения одной или нескольких ограничений еще не приговор.

- Нелинейность регрессии может быть преодолена преобразованием переменных, например через функцию натурального логарифма ln .

- Таким же способом возможно решить проблему неоднородной дисперсии, с помощью ln , или sqrt преобразований зависимой переменной, либо же используя взвешенный МНК.

- Для устранения проблемы мультиколлинеарности применяется метод исключения переменных. Суть его в том, что высоко коррелированные объясняющие переменные устраняются из регрессии, и она заново оценивается. Критерием отбора переменных, подлежащих исключению, является коэффициент корреляции. Есть еще один способ решения данной проблемы, который заключается в замене переменных, которым присуща мультиколлинеарность, их линейной комбинацией. Этим весь список не исчерпывается, есть еще пошаговая регрессия и другие методы.

К сожалению, не все нарушения условий и дефекты линейной регрессии можно устранить с помощью натурального логарифма. Если имеет место автокорреляция возмущений к примеру, то лучше отступить на шаг назад и построить новую и лучшую модель.

Линейная регрессия плюсов на Хабре

Итак, довольно теоретического багажа и можно строить саму модель.

Мне давно было любопытно от чего зависит та самая зелененькая цифра, что указывает на рейтинг поста на Хабре. Собрав всю доступную статистику собственных постов, я решил прогнать ее через модель линейно регрессии.

Загружает данные из tsv файла.

- points — Рейтинг статьи

- reads — Число просмотров.

- comm — Число комментариев.

- faves — Добавлено в закладки.

- fb — Поделились в социальных сетях (fb + vk).

- bytes — Длина в байтах.

Вопреки моим ожиданиям наибольшая отдача не от количества просмотров статьи, а от комментариев и публикаций в социальных сетях. Я также полагал, что число просмотров и комментариев будет иметь более сильную корреляцию, однако зависимость вполне умеренная — нет надобности исключать ни одну из независимых переменных.

Теперь собственно сама модель, используем функцию lm .

В первой строке мы задаем параметры линейной регрессии. Строка points

. определяет зависимую переменную points и все остальные переменные в качестве регрессоров. Можно определить одну единственную независимую переменную через points

reads , набор переменных — points

Перейдем теперь к расшифровке полученных результатов.

- Intercept — Если у нас модель представлена в виде

, то тогда

— точка пересечения прямой с осью координат, или intercept .

- R-squared — Коэффициент детерминации указывает насколько тесной является связь между факторами регрессии и зависимой переменной, это соотношение объясненных сумм квадратов возмущений, к необъясненным. Чем ближе к 1, тем ярче выражена зависимость.

- Adjusted R-squared — Проблема с

в том, что он по любому растет с числом факторов, поэтому высокое значение данного коэффициента может быть обманчивым, когда в модели присутствует множество факторов. Для того, чтобы изъять из коэффициента корреляции данное свойство был придуман скорректированный коэффициент детерминации .

- F-statistic — Используется для оценки значимости модели регрессии в целом, является соотношением объяснимой дисперсии, к необъяснимой. Если модель линейной регрессии построена удачно, то она объясняет значительную часть дисперсии, оставляя в знаменателе малую часть. Чем больше значение параметра — тем лучше.

- t value — Критерий, основанный на t распределении Стьюдента . Значение параметра в линейной регрессии указывает на значимость фактора, принято считать, что при t > 2 фактор является значимым для модели.

- p value — Это вероятность истинности нуль гипотезы, которая гласит, что независимые переменные не объясняют динамику зависимой переменной. Если значение p value ниже порогового уровня (.05 или .01 для самых взыскательных), то нуль гипотеза ложная. Чем ниже — тем лучше.

Можно попытаться несколько улучшить модель, сглаживая нелинейные факторы: комментарии и посты в социальных сетях. Заменим значения переменных fb и comm их степенями.

Проверим значения параметров линейной регрессии.

Как видим в целом отзывчивость модели возросла, параметры подтянулись и стали более шелковистыми , F-статистика выросла, так же как и скорректированный коэффициент детерминации .

Проверим, соблюдены ли условия применимости модели линейной регрессии? Тест Дарбина-Уотсона проверяет наличие автокорреляции возмущений.

И напоследок проверка неоднородности дисперсии с помощью теста Бройша-Пагана.

В заключение

Конечно наша модель линейной регрессии рейтинга Хабра-топиков получилось не самой удачной. Нам удалось объяснить не более, чем половину вариативности данных. Факторы надо чинить, чтобы избавляться от неоднородной дисперсии, с автокорреляцией тоже непонятно. Вообще данных маловато для сколь-нибудь серьезной оценки.

Но с другой стороны, это и хорошо. Иначе любой наспех написанный тролль-пост на Хабре автоматически набирал бы высокий рейтинг, а это к счастью не так.

Регрессионный анализ

В этом разделе

Регрессионный анализ статистический аналитический метод, позволяющий вычислить предполагаемые отношения между зависимой переменной одной или несколькими независимыми переменными. Используя регрессионный анализ, вы можете моделировать отношения между выбранным переменными, а также прогнозируемыми значениями на основе модели.

Обзор регрессионного анализа

Регрессионный анализ использует выбранный метод оценки, зависимую переменную и одну или несколько независимых переменных для создания уравнения, которое оценивает значения зависимой переменной.

Модель регрессии включает выходные данные, например R 2 и p-значения, по которым можно понять, насколько хорошо модель оценивает зависимую переменную.

Диаграммы, например матрица точечной диаграммы, гистограмма и точечная диаграмма, также используются в регрессионном анализе для анализа отношений и проверки допущений.

Регрессионный анализ используется для решения следующих типов проблем:

- Выявить, какая независимая переменная связана с зависимой.

- Понять отношения между зависимой и независимыми переменными.

- Предсказать неизвестные значения зависимой переменной.

Примеры

Аналитик в рамках исследования для небольшой розничной сети изучает эффективность работы различных магазинов. Он хочет выяснить, почему некоторые магазины показывают очень небольшой объем продаж. Аналитик строит модель регрессии с независимыми переменными, такими как средний возраст и средний доход жителей, проживающих вокруг магазинов, а так же расстояние до торговых центров и остановок общественного транспорта, чтобы выявить, какая именно переменная наиболее влияет на продажи.

Аналитик департамента образования исследует эффективность новой программы питания в школе. Аналитик строит модель регрессии для показателей успеваемости, используя такие независимые переменные, как размер класса, доход семьи, размер подушевого финансирования учащихся и долю учащихся, питающихся в школе. Уравнение модели используется для выявления относительного вклада каждой переменной в показатели успеваемости учебного заведения.

Аналитик неправительственной организации изучает эффект глобальных выбросов парниковых газов. Аналитик строит модель регрессии для выбросов в последнее время, зафиксированных в каждой стране, используя независимые переменные, такие как валовой внутренний продукт( ВВП), численность населения, производство электроэнергии с использованием добываемого углеводородного топлива и использование транспортных средств. Эту модель можно использовать использована для прогнозирования будущих выбросов парниковых газов на основе предполагаемых значений значений ВВП и численности населения.

Наименьшие квадраты

Регрессионный анализ в ArcGIS Insights моделируется на основе Метода наименьших квадратов (МНК).

МНК – форма множественной линейной регрессии, допускающей, что отношения между зависимыми и независимыми переменными должны моделироваться подгонкой линейного уравнения к данным наблюдений.

МНК использует следующее уравнение:

, где:

- yi=наблюдаемое=наблюдаемое значение независимой переменной в точке i

- β0=y-интерсепт (отрезок на координатной оси, постоянное значение)

- βn=коэффициент регрессии или уклона независимой переменной N в точке i

- xn=значение переменной N в точке i

- ε=ошибка уравнения регрессии

Допущения (Предположения)

Каждый метод регрессии имеет несколько допущений, которые должны быть выполнены для того, чтобы уравнение считалось надежным. Допущения МНК должны быть проверены при создании модели регрессии.

Модель должна быть линейной.

Регрессия МНК используется только при построении линейной модели. Линейную зависимость между зависимой и независимыми переменными можно проверить используя точечную диаграмму (рассеивания). Матрица точечной диаграммы может проверить все переменные, при условии, что всего используется не более 5 переменных.

Данные должны быть распределены произвольно.

Данные, используемые в регрессионном анализе, должны быть произвольно распределены, то есть выборки данных не должны зависеть от какого-либо внешнего фактора. Произвольное распределение можно проверить, используя невязки в модели регрессии. Невязки, рассчитываемые как результат модели регрессии, не должны коррелировать при нанесении их на точечную диаграмму или матрицу точечной диаграммы вместе с независимыми переменными.

Независимые переменные не должны быть коллинеарны.

Коллинеарность — это линейная связь между независимыми переменными, которая создает избыточность в модели. В ряде случаев модель создается с коллинеарностью. Тем не менее, если одна из коллинеарных переменных зависит от другой, возможно, стоит удалить ее из модели. Оценить коллинеарность можно с помощью точечной диаграммы или матрицы точечной диаграммы независимых переменных.

Независимые переменные должны иметь незначительную погрешность измерения.

Точность модели регрессии соответствует точности входных данных. Если независимые переменные имеют большой разброс ошибок, модель нельзя считать точной. При выполнении регрессионного анализа очень важно использовать наборы данных только из известных и доверенных источников, чтобы быть уверенным в незначительности ошибок.

Предполагаемая сумма невязок должна быть равна нулю.

Невязки представляют собой разность между ожидаемыми и наблюдаемыми значениями в регрессионном анализе. Наблюдаемые значения выше кривой регрессии имеют положительное значение невязки, а значения ниже кривой регрессии – отрицательные. Кривая регрессии должны проходить через центр точек данных; соответственно сумма невязок должны стремиться к нулю. Сумму значений поля можно вычислить в суммарной таблице.

Невязки должны иметь равномерную вариабельность.

Величина вариабельности должна быть одинаковой для всех невязок. Это допущение проверяется с использованием точечной диаграммы невязок (ось y) и оцениваемых значений (ось x). Результирующая точечная диаграмма отображается как горизонтальная полоса с произвольно разбросанными точками по всей площади.

Распределение невязок должно соответствовать нормальному.

Нормальное распределение – кривая в форме колокола – является естественным распределением, где высокая частота явления наблюдается рядом со средним значением, и по мере увеличения расстояния от среднего частота снижается. В статистическом анализе нормальное распределение часто используется как нулевая гипотеза. Если распределение невязок соответствует нормальному, линия наилучшего соответствия проходит по центру наблюдаемых точек данных, а не отклоняется, приближаясь к одним, и отклоняясь от других. Это допущение можно проверить, построив гистограмму невязок. Кривая нормального распределения может не поместиться в карточку и сдвиги и эксцессы переносятся на обратную сторону карточки гистограммы.

Смежные невязки не должны обнаруживать автокорреляцию.

Это допущение основано на хронологии данных. Если данные соответствуют хронологии, каждая точка данных должна быть независима от предыдущей или последующей точки данных. Поэтому при выполнении регрессионного анализа важно убедиться, что хронологический порядок данных соответствует нормальному ходу времени. Это допущение вычисляется с использованием теста Дарбина-Уотсона.

Тест Дарбина-Уотсона измеряет автокорреляцию невязок в модели регрессии. Критерий Дурбина-Ватсона использует шкалу от 0 до 4, где значения от 0 до 2 указывают на положительную автокорреляцию, 2 – отсутствие автокорреляции, а от 2 до 4 отрицательную автокорреляцию. То есть, чтобы соответствовать допущению об отсутствии автокорреляции невязок, необходимо получить значение, приближающееся к 2. В целом, значения между 1.5 и 2.5 считаются допустимыми, а меньше 1.5 или больше 2.5 указывают на то, что модель не соответствует утверждению об отсутствии автокорреляции.

Пригодность модели

Точность уравнения регрессии – основа регрессионного анализа. Все модели будут иметь некую ошибку, но понимание этой статистики поможет вам определить, можно ли использовать эту модель для вашего анализа, или необходимо выполнить дополнительные преобразования.

Существуют два метода проверки корректности модели регрессии: исследовательский анализ и подтверждающий анализ.

Исследовательский анализ

Исследовательский анализ – технология анализа данных с использованием разнообразных статистических и визуальных методов. В рамках исследовательского анализа вы проверяете допущения регрессии МНК и сравниваете эффективность различных независимых переменных. Исследовательский анализ позволяет вам сравнить эффективность и точность разных моделей, но не может определить, должны ли вы использовать или отклонить ту или иную модель. Исследовательский анализ необходимо проводить перед анализом подтверждения для каждой модели регрессии, возможно, несколько раз, для сравнения разных моделей.

Как часть исследовательского анализа могут быть использованы следующие диаграммы и статистические показатели:

- Точечная диаграмма (рассеяния) и матрица точечной диаграммы

- Гистограмма и анализ нормального распределения

- Уравнение регрессии и прогнозирование новых наблюдений

- Коэффициент детерминации, R 2 и скорректированный R 2

- Стандартная ошибка невязки

- Точечная диаграмма

Исследовательский анализ начинается, когда вы выбираете независимые переменные, и до построения модели регрессии. Так как МНК – метод линейной регрессии, основное допущение – модель должна быть линейной. Точечная диаграмма (рассеяния) и матрица точечной диаграммы могут быть использованы для анализа линейной зависимости между зависимой переменной и независимыми переменными. Матрица точечной диаграммы может отобразить до 4х независимых переменных с зависимой переменной, что позволяет сразу провести сравнение между всеми переменными. Простая диаграмма рассеяния может отобразить только две переменные: одну зависимую и одну независимую. Просмотр диаграммы рассеяния с зависимой переменной и одной независимой переменной позволяет сделать более точное допущение об отношении между переменными. Линейность можно проверить перед созданием модели регрессии, чтобы определить, какие именно независимые переменные следует использовать для создания пригодной модели.

Несколько выходных статистических показателей также доступны после создания модели регрессии, к ним относятся: уравнение регрессии, значение R 2 и критерий Дурбина-Ватсона. После создания модели регрессии вы должны использовать выходные показатели, а также диаграммы и таблицы для проверки остальных допущений регрессии МНК. Если ваша модель удовлетворяет допущениям, вы можете продолжить исследовательский анализ.

Уравнение регрессии дает возможность оценить влияние каждой независимой переменной на прогнозируемые значения, включая коэффициент регрессии для каждой независимой переменной. Можно сравнить величины уклона для определения влияния каждой независимой переменной на зависимую переменную; Чем дальше от нуля значение уклона (неважно, в положительную, или отрицательную сторону) – тем больше влияние. Уравнение регрессии также может быть использовано для прогнозирования значений зависимой переменной через вод значений каждой независимой переменной.

Коэффициент детерминации, обозначаемый как R 2 , измеряет, насколько хорошо уравнение регрессии моделирует фактические точки данных. Значение R 2 – число в диапазоне от 0 до 1, причем, чем ближе значение к 1, тем более точная модель. Если R 2 равен 1, это указывает на идеальную модель, что крайне маловероятно в реальных ситуациях, учитывая сложность взаимодействий между различными факторами и неизвестными переменными. Поэтому следует стремиться к созданию регрессионной модели с максимально возможным значением R 2 , понимая, что значение не может быть равно 1.

При выполнении регрессионного анализа существует риск создания модели регрессии, имеющей допустимое значение R 2 , путем добавления независимых переменных, случайным образом показывающих хорошее соответствие. Значение Скорректированный R 2 , которое также должно находиться в диапазоне между 0 и 1, учитывает дополнительные независимые переменные, уменьшая роль случайности в вычислении. Скорректированный R 2 нужно использовать в модели с большим количеством независимых переменных или при сравнении моделей с различным числом независимых переменных.

Стандартная ошибка невязки измеряет точность, с которой регрессионная модель может предсказывать значения с новыми данными. Меньшие значения указывают на более точную модель, соответственно при сравнении нескольких моделей, та, где это значение самое меньшее из всех – модель, в которой минимизирована стандартная ошибка невязки.

Точечная диаграмма может быть использована для анализа независимых переменных, с целью выявления кластеризации или выбросов, которые могут влиять на точность модели.

Анализ подтверждения

Анализ подтверждения — процесс оценки модели в сравнении с нулевой гипотезой. В регрессионном анализа нулевая гипотеза утверждает, что отношения между зависимой и независимыми переменными отсутствуют. Для модели с отсутствием отношений величина уклона равна 0. Если элементы анализа подтверждения статистически значимы — вы можете отклонить нулевую гипотезу ((другими словами, статистически подтверждается наличие отношений между зависимой и независимыми переменными).

Для определения значимости, как компонента анализа, используются следующие статистические показатели:

- F-статистика, и связанное с ней p-значение

- T-статистика, и связанное с ней p-значение

- Доверительные интервалы

F-статистика — глобальный статистический показатель, возвращаемый F-критерием, который показывает возможности прогнозирования модели через расчет коэффициентов регрессии в модели, которые значительно отличаются от 0. F-критерий анализирует комбинированное влияние независимых переменных, а не оценивает каждую в отдельности. С F-статистикой связано соответствующее p-значение, которое является мерой вероятности того, что детерминированные отношения между переменными являются случайными Так как p-значения базируются на вероятности, значения располагаются в диапазоне от 0.0 до 1.0. Небольшое p-значение, обычно 0.05 или меньше, свидетельствует о том, что в модели реально есть отношения между переменными (то есть, выявленная закономерность не является случайной) что дает нам право отвергнуть нулевую гипотезу. В этом случае, вероятность того, что отношения в модели случайны, равна 0.05, или 1 к 20. Или, вероятность того, что отношения реальны, равна 0.95, или 19 к 20.

Показатель t-статистика — это локальный статистический показатель, возвращаемый t-критерием, который показывает возможности прогнозирования для каждой независимой переменной отдельно. Так же, как и F-критерий, t-критерий анализирует коэффициенты регрессии в модели, которые значительно отличаются от 0. Так как t-критерий применяется к каждой независимой переменной, модель вернет значение t-статистики для каждой независимой переменной, а не одно значение для всей модели. Каждое значение t-статистики имеет связанное с ним p-значение, которое указывает на значимость независимой переменной. Так же, как и для F-критерия, p-значение для каждого t-критерия должно быть 0.05 или менее, чтобы мы могли отвергнуть нулевую гипотезу. Если p-значение для независимой переменной больше 0.05, эту переменную не стоит включать в модель, и необходимо строить новую модель, даже если глобальное значение вероятности для исходной модели указывает на статистическую значимость.

Доверительные интервалы визуализируют коэффициенты регрессии для каждой независимой переменной и могут быть 90, 95 и 99 процентов. Поэтому доверительные интервалы можно использовать наряду с p-значениями t-критерия для оценки значимости нулевой гипотезы для каждой независимой переменной. Коэффициенты регрессии на должны быть равны 0, только в этом случае вы можете отклонить нулевую гипотезу и продолжить использовать модель. Поэтому, для каждой независимой переменной, коэффициент регрессии, и связанный с ним доверительный интервал не может перекрываться с 0. Если доверительные интервалы в 99 или 95 процентов для данной независимой переменой перекрываются с 0, эта независимая переменная не дает возможности отклонить нулевую гипотезу. Включение этой переменной в модель может негативно повлиять на общую значимость вашей модели. Если только 90-процентный доверительный интервал перекрывается с 0, эта переменная может быть включена в модель, общая статистическая значимость которой вас удовлетворяет. В идеале, доверительные интервалы для всех независимых переменных должны быть как можно дальше от 0.

Другие выходные данные

Остальные выходные данные, такие как прогнозируемые значения и невязки также важны для допущений регрессии МНК. В этом разделе вы можете узнать подробнее, как эти значения вычисляются.

Ожидаемые значения

Ожидаемые значения вычисляются на основе уравнения регрессии и значений каждой независимой переменной. В идеале, ожидаемые значения должны совпадать с наблюдаемыми (реальными значениями зависимой переменной).

Ожидаемые значения, вместе с наблюдаемым значениями, используются для вычисления невязок.

Невязки

Невязки в регрессионном анализе – это различия между наблюдаемыми значениями в наборе данных и ожидаемыми значениями, вычисленными с помощью уравнения регрессии.

Невязки A и B для отношений выше вычисляются следующим образом:

Невязки используются для вычисления ошибки уравнения регрессии, а также для проверки некоторых допущений.

Парная линейная регрессия. Задачи регрессионного анализа

Будут и задачи для самостоятельного решения, к которым можно посмотреть ответы.

Понятие линейной регрессии. Парная линейная регрессия

Линейная регрессия — выраженная в виде прямой зависимость среднего значения какой-либо величины от некоторой другой величины. В отличие от функциональной зависимости y = f(x) , когда каждому значению независимой переменной x соответствует одно определённое значение величины y, при линейной регрессии одному и тому же значению x могут соответствовать в зависимости от случая различные значения величины y.

Если в результате наблюдения установлено, что при каждом определённом значении x существует сколько-то (n) значений переменной y, то зависимость средних арифметических значений y от x и является регрессией в статистическом понимании.

Если установленная зависимость может быть записана в виде уравнения прямой

то эта регрессионная зависимость называется линейной регрессией.

О парной линейной регрессии говорят, когда установлена зависимость между двумя переменными величинами (x и y). Парная линейная регрессия называется также однофакторной линейной регрессией, так как один фактор (независимая переменная x) влияет на результирующую переменную (зависимую переменную y).

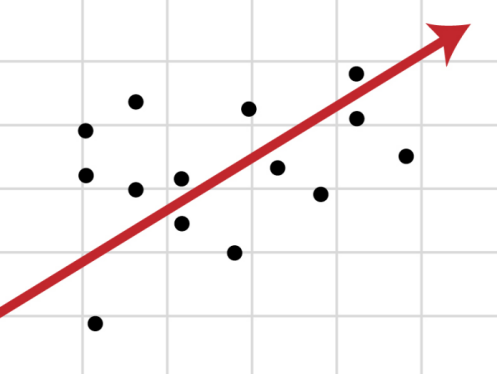

В уроке о корреляционной зависимости были разобраны примеры того, как цена на квартиры зависит от общей площади квартиры и от площади кухни (две различные независимые переменные) и о том, что результаты наблюдений расположены в некотором приближении к прямой, хотя и не на самой прямой. Если точки корреляционной диаграммы соединить ломанной линией, то будет получена линия эмпирической регрессии. А если эта линия будет выровнена в прямую, то полученная прямая будет прямой теоретической регрессии. На рисунке ниже она красного цвета (для увеличения рисунка щёлкнуть по нему левой кнопкой мыши).

По этой прямой теоретической регрессии может быть сделан прогноз или восстановление неизвестных значений зависимой переменной по заданным значениям независимой переменной.

В случае парной линейной регрессии для данных генеральной совокупности связь между независимой переменной (факториальным признаком) X и зависимой переменной (результативным признаком) Y описывает модель

N — число элементов генеральной совокупности.

Уравнение парной линейной регрессии для генеральной совокупности можно построить, если доступны данные обо всех элементах генеральной совокупности. На практике данные всей генеральной совокупности недоступны, но доступны данные об элементах некоторой выборки.

Поэтому параметры генеральной совокупности оценивают при помощи соответствующих параметров соответствующей выборки: свободный член прямой парной линейной регрессии генеральной совокупности

В результате получаем уравнение парной линейной регрессии выборки

n — размер выборки.

Чтобы уравнение парной линейной регрессии было более похоже на привычное уравнение прямой, его часто также записывают в виде

Уравнение парной линейной регрессии и метод наименьших квадратов

Определение коэффициентов уравнения парной линейной регрессии

Если заранее известно, что зависимость между факториальным признаком x и результативным признаком y должна быть линейной, выражающейся в виде уравнения типа

Если через

- прямая парной линейной регрессии проходит через точку

;

- среднее значение отклонений равна нулю:

;

- значения

и

не связаны:

.

Условие метода наименьших квадратов выполняется, если значения коэффициентов равны:

Пример 1. Найти уравнение парной линейной регрессии зависимости между валовым внутренним продуктом (ВВП) и частным потреблением на основе данных примера урока о корреляционной зависимости (эта ссылка, которая откроется в новом окне, потребуется и при разборе следующих примеров).

Решение. Используем рассчитанные в решении названного выше примера суммы:

Используя эти суммы, вычислим коэффициенты:

Таким образом получили уравнение прямой парной линейной регрессии:

Составить уравнение парной линейной регрессии самостоятельно, а затем посмотреть решение

Пример 2. Найти уравнение парной линейной регрессии для выборки из 6 наблюдений, если уже вычислены следующие промежуточные результаты:

Анализ качества модели линейной регрессии

Метод наименьших квадратов имеет по меньшей мере один существенный недостаток: с его помощью можно найти уравнение линейной регрессии и в тех случаях, когда данные наблюдений значительно рассеяны вокруг прямой регрессии, то есть находятся на значительном расстоянии от этой прямой. В таких случаях за точность прогноза значений зависимой переменной ручаться нельзя. Существуют показатели, которые позволяют оценить качество уравнения линейной регрессии прежде чем использовать модели линейной регрессии для практических целей. Разберём важнейшие из этих показателей.

Коэффициент детерминации

Коэффициент детерминации

Пример 3. Даны сумма квадратов отклонений, объясняемых моделью линейной регрессии (3500), общая сумма квадратов отклонений (5000) и сумма квадратов отклонений ошибки (1500). Найти коэффициент детерминации двумя способами.

F-статистика (статистика Фишера) для проверки качества модели линейной регрессии

Минимальное возможное значение F-статистики — 0. Чем выше значение статистики Фишера, тем качественнее модель линейной регрессии. Этот показатель представляет собой отношение объясненной суммы квадратов (в расчете на одну независимую переменную) к остаточной сумме квадратов (в расчете на одну степень свободы):

где m — число объясняющих переменных.

Сумма квадратов остатков

Сумма квадратов остатков (RSS) измеряет необъясненную часть дисперсии зависимой переменной:

остатки — разности между реальными значениями зависимой переменной и значениями, оценёнными уравнением линейной регрессии.

В случае качественной модели линейной регрессии сумма квадратов остатков стремится к нулю.

Стандартная ошибка регрессии

Стандартная ошибка регрессии (SEE) измеряет величину квадрата ошибки, приходящейся на одну степень свободы модели:

Чем меньше значение SEE, тем качественнее модель.

Пример 4. Рассчитать коэффициент детерминации для данных из примера 1.

Решение. На основании данных таблицы (она была приведена в примере урока о корреляционной зависимости) получаем, что SST = 63 770,593 , SSE = 10 459,587 , SSR = 53 311,007 .

Можем убедиться, что выполняется закономерность SSR = SST — SSE :

Получаем коэффициент детерминации:

Таким образом, 83,6% изменений частного потребления можно объяснить моделью линейной регресии.

Интерпретация коэффициентов уравнения парной линейной регрессии и прогноз значений зависимой переменной

Итак, уравнение парной линейной регрессии:

В этом уравнении a — свободный член, b — коэффициент при независимой переменной.

Интерпретация свободного члена: a показывает, на сколько единиц график регрессии смещён вверх при x=0, то есть значение переменной y при нулевом значении переменной x.

Интерпретация коэффициента при независимой переменной: b показывает, на сколько единиц изменится значение зависимой переменной y при изменении x на одну единицу.

Пример 5. Зависимость частного потребления граждан от ВВП (истолкуем это просто: от дохода) описывается уравнением парной линейной регрессии

Решение. Подставляем в уравнение парной линейной регрессии x i = 20000 и получаем прогноз потребления при доходе в 20 000 у.е. y i = 17036,4662 .

Подставляем в уравнение парной линейной регрессии x i = 5000 и получаем прогноз увеличения потребления при увеличении дохода на 5000 у.е. y i = 4161,9662 .

Если доход не меняется, то x i = 0 и получаем, что потребление уменьшается на 129,5338 у.е.

Задачи регрессионного анализа

Регрессионный анализ — раздел математической статистики, объединяющий практические методы исследования регрессионной зависимости между величинами по статистическим данным.

Наиболее частые задачи регрессионного анализа:

- установление факта наличия или отсутствия статистических зависимостей между переменными величинами;

- выявление причинных связей между переменными величинами;

- прогноз или восстановление неизвестных значений зависимых переменных по заданным значениям независимых переменных.

Также делаются проверки статистических гипотез о регрессии. Кроме того, при изучении связи между двумя величинами по результатам наблюдений в соответствии с теорией регрессии предполагается, что зависимая переменная имеет некоторое распределение вероятностей при фиксированном значении независимой переменной.

В исследованиях поведения человека, чтобы они претендовали на объективность, важно не только установить зависимость между факторами, но и получить все необходимые статистические показатели для результата проверки соответствующей гипотезы.

Проверка гипотезы о равенстве нулю коэффициента направления прямой парной линейной регрессии

Одна из важнейших гипотез в регрессионном анализе — гипотеза о том, что коэффициент направления прямой регрессии генеральной совокупности

Если это предположение верно, то изменения независимой переменной X не влияют на изменения зависимой переменной Y: переменные X и Y не коррелированы, то есть линейной зависимости Y от X нет.

рассматривают во взаимосвязи с альтернативной гипотезой

Статистика коэффициента направления

соответствует распределению Стьюдента с числом степеней свободы v = n — 2 ,

где

Доверительный интервал коэффициента направления прямой линейной регрессии:

Критическая область, в которой с вероятностью P = 1 — α отвергают нулевую гипотезу и принимают альтернативную гипотезу:

Пример 6. На основе данных из предыдущих примеров (о ВВП и частном потреблении) определить доверительный интервал коэффициента направления прямой линейной регресии 95% и проверить гипотезу о равенстве нулю коэффициента направления прямой парной линейной регрессии.

Можем рассчитать, что

Таким образом, стандартная погрешность коэффициента направления прямой линейной регресии b 1 :

Так как

Так как гипотетическое значение коэффициента — нуль — не принадлежит доверительному интервалу, с вероятностью 95% можем отвергнуть основную гипотезу и принять альтернативную гипотезу, то есть считать, что зависимая переменная Y линейно зависит от независимой переменной X.

http://doc.arcgis.com/ru/insights/latest/analyze/regression-analysis.htm

http://function-x.ru/statistics_regression1.html

;

; ;

; и

и  не связаны:

не связаны:  .

.