Нелинейные системы и уравнения

В более общем случае мы имеем не одно уравнение (1), а систему нелинейных уравнений $$ \begin

Метод Ньютона

Решение нелинейных уравнений

При итерационном решении уравнений (1), (3) задается некоторое начальное приближение, достаточно близкое к искомому решению \( x^* \). В одношаговых итерационных методах новое приближение \( x_

В итерационном методе Ньютона (методе касательных) для нового приближения имеем $$ \begin

Вычисления по (4) проводятся до тех пор, пока \( f(x_k) \) не станет близким к нулю. Более точно, до тех пор, пока \( |f_(x_k)| > \varepsilon \), где \( \varepsilon \) — малая величина.

Простейшая реализация метода Ньютона может выглядеть следующим образом:

Чтобы найти корень уравнения \( x^2 = 9 \) необходимо реализовать функции

Данная функция хорошо работает для приведенного примера. Однако, в общем случае могут возникать некоторые ошибки, которые нужно отлавливать. Например: пусть нужно решить уравнение \( \tanh(x) = 0 \), точное решение которого \( x = 0 \). Если \( |x_0| \leq 1.08 \), то метод сходится за шесть итераций.

Теперь зададим \( x_0 \) близким к \( 1.09 \). Возникнет переполнение

Возникнет деление на ноль, так как для \( x_7 = -126055892892.66042 \) значение \( \tanh(x_7) \) при машинном округлении равно \( 1.0 \) и поэтому \( f^\prime(x_7) = 1 — \tanh(x_7)^2 \) становится равной нулю в знаменателе.

Проблема заключается в том, что при таком начальном приближении метод Ньютона расходится.

Еще один недостаток функции naive_Newton заключается в том, что функция f(x) вызывается в два раза больше, чем необходимо.

Учитывая выше сказанное реализуем функцию с учетом следующего:

- обрабатывать деление на ноль

- задавать максимальное число итераций в случае расходимости метода

- убрать лишний вызов функции f(x)

Метод Ньютона сходится быстро, если начальное приближение близко к решению. Выбор начального приближение влияет не только на скорость сходимости, но и на сходимость вообще. Т.е. при неправильном выборе начального приближения метод Ньютона может расходиться. Неплохой стратегией в случае, когда начальное приближение далеко от точного решения, может быть использование нескольких итераций по методу бисекций, а затем использовать метод Ньютона.

При реализации метода Ньютона нужно знать аналитическое выражение для производной \( f^\prime(x) \). Python содержит пакет SymPy, который можно использовать для создания функции dfdx . Для нашей задачи это можно реализовать следующим образом:

Решение нелинейных систем

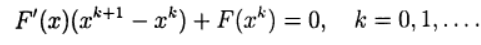

Идея метода Ньютона для приближенного решения системы (2) заключается в следующем: имея некоторое приближение \( \pmb

Таким образом, \( k \)-я итерация метода Ньютона состоит из двух стадий:

1. Решается система линейных уравнений (СЛАУ) \( \pmb

2. Находится значение вектора на следующей итерации \( \pmb

Для решения СЛАУ можно использовать приближенные методы. Можно также использовать метод Гаусса. Пакет numpy содержит модуль linalg , основанный на известной библиотеке LAPACK, в которой реализованы методы линейной алгебры. Инструкция x = numpy.linalg.solve(A, b) решает систему \( Ax = b \) методом Гаусса, реализованным в библиотеке LAPACK.

Когда система нелинейных уравнений возникает при решении задач для нелинейных уравнений в частных производных, матрица Якоби часто бывает разреженной. В этом случае целесообразно использовать специальные методы для разреженных матриц или итерационные методы.

Можно также воспользоваться методами, реализованными для систем линейных уравнений.

Численные методы решения систем нелинейных уравнений

Введение

Многие прикладные задачи приводят к необходимости нахождения общего решения системы нелинейных уравнений. Общего аналитического решения системы нелинейных уравнений не найдено. Существуют лишь численные методы.

Следует отметить интересный факт о том, что любая система уравнений над действительными числами может быть представлена одним равносильным уравнением, если взять все уравнения в форме

Для численного решения применяются итерационные методы последовательных приближений (простой итерации) и метод Ньютона в различных модификациях. Итерационные процессы естественным образом обобщаются на случай системы нелинейных уравнений вида:

Обозначим через

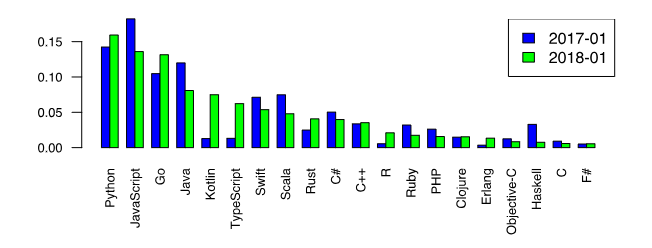

Теперь вернёмся к всеми любимому Python и отметим его первенство среди языков программирования, которые хотят изучать [1].

Этот факт является дополнительным стимулом рассмотрения числительных методов именно на Python. Однако, среди любителей Python бытует мнение, что специальные библиотечные функции, такие как scipy.optimize.root, spsolve_trianular, newton_krylov, являются самым лучшим выбором для решения задач численными методами.

С этим трудно не согласится хотя бы потому, что в том числе и разнообразие модулей подняло Python на вершину популярности. Однако, существуют случаи, когда даже при поверхностном рассмотрении использование прямых известных методов без применения специальных функций библиотеки SciPy тоже дают неплохие результаты. Иными словами, новое- это хорошо забытое старое.

Так, в публикации [2], на основании проведенных вычислительных экспериментов, доказано, что библиотечная функция newton_krylov, предназначенная для решения больших систем нелинейных уравнений, имеет в два раза меньшее быстродействие, чем алгоритм TSLS+WD

(two-step least squares), реализованный средствами библиотеки NumPy.

Целью настоящей публикации является сравнение по числу итераций, быстродействию, а главное, по результату решения модельной задачи в виде системы из ста нелинейных алгебраических уравнений при помощи библиотечной функции scipy.optimize.root и методом Ньютона, реализованного средствами библиотеки NumPy.

Возможности решателя scipy.optimize.root для численного решения систем алгебраических нелинейных уравнений

Библиотечная функция scipy.optimize.root выбрана в качестве базы сравнения, потому что имеет обширную библиотеку методов, пригодных для сравнительного анализа.

scipy.optimize.root(fun, x0, args=(), method=’hybr’, jac=None, tol=None,callback=None, ptions=None)

fun — Векторная функция для поиска корня.

x0 –Начальные условия поиска корней

method:

hybr -используется модификация Пауэлл гибридный метод;

lm – решает системы нелинейных уравнений методом наименьших квадратов.

Как следует из документации [3] методы broyden1, broyden2, anderson, linearmixing, diagbroyden, excitingmixing, krylov являются точными методами Ньютона. Остальные параметры являются «не обязательными» и с ними можно ознакомится в документации.

Методы решения систем нелинейных уравнений

Приведенный далее материал действительно можно прочитать в литературе, например в [4], но я уважаю своего читателя и для его удобства приведу вывод метода по возможности в сокращенном виде. Те, кто не любит формулы, этот раздел пропускают.

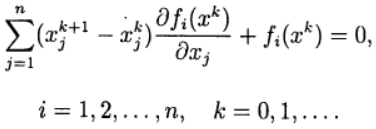

В методе Ньютона новое приближение для решения системы уравнений (2) определяется из решения системы линейных уравнений:

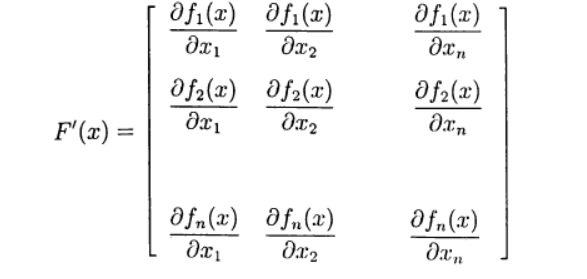

Определим матрицу Якоби:

Запишем(3) в виде:

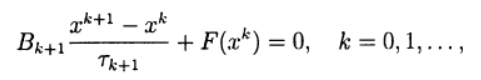

Многие одношаговые методы для приближенного решения (2) по аналогии с двухслойными итерационными методами для решения систем линейных алгебраических уравнений можно записать в виде:

где

При использовании записи (6) метод Ньютона (5) соответствует выбору:

Система линейных уравнений (5) для нахождения нового приближения

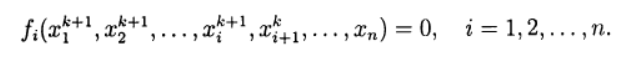

При решении систем нелинейных уравнений можно использовать прямые аналоги стандартных итерационных методов, которые применяются для решения систем линейных уравнений. Нелинейный метод Зейделя применительно к решению (2) дает:

В этом случае каждую компоненту нового приближения из решения нелинейного уравнения, можно получить на основе метода простой итерации и метода Ньютона в различных модификациях. Тем самым снова приходим к двухступенчатому итерационному методу, в котором внешние итерации проводятся в соответствии с методом Зейделя, а внутренние — с методом Ньютона.

Основные вычислительные сложности применения метода Ньютона для приближенного решения систем нелинейных уравнений связаны с необходимостью решения линейной системы уравнений с матрицей Якоби на каждой итерации, причем от итерации к итерации эта матрица меняется. В модифицированном методе Ньютона матрица Якоби обращается только один раз:

Выбор модельной функции

Такой выбор не является простой задачей, поскольку при увеличении числа уравнений в системе в соответствии с ростом числа переменных результат решения не должен меняться, поскольку в противном случае невозможно отследить правильность решения системы уравнений при сравнении двух методов. Привожу следующее решение для модельной функции:

Функция f создаёт систему из n нелинейных уравнений, решение которой не зависит от числа уравнений и для каждой из n переменных равно единице.

Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью библиотечной функции optimize.root для разных методов отыскания корней

Только один из методов, приведенных в документации [3] прошёл тестирование по результату решения модельной функции, это метод ‘krylov’.

Решение для n=100:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1.]

Krylov method iteration = 4219

Optimize root time 7.239 seconds:

Вывод: С увеличением числа уравнений вдвое заметно появление ошибок в решении. При дальнейшем увеличении n решение становится не приемлемым, что возможно из-за автоматической адаптации к шагу, эта же причина резкого падения быстродействия. Но это только моё предположение.

Программа для тестирования на модельной функции c результатами решения системы алгебраических нелинейных уравнений с помощью программы написанной на Python 3 с учётом соотношений (1)-(8) для отыскания корней по модифицированному методу Ньютона

Решение для n=100:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1.]

Newton iteration = 13

Newton method time 0.496 seconds

Решение для n=200:

Solution:

[1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1. 1.

1. 1. 1. 1. 1. 1. 1. 1.]

Newton iteration = 14

Newton method time 1.869 seconds

Чтобы убедиться в том, что программа действительно решает систему, перепишем модельную функцию для ухода от корня со значением 1 в виде:

Получим:

Solution:

[ 0.96472166 0.87777036 0.48175823 -0.26190496 -0.63693762 0.49232062

-1.31649896 0.6865098 0.89609091 0.98509235]

Newton iteration = 16

Newton method time 0.046 seconds

Вывод: Программа работает и при изменении модельной функции.

Теперь вернёмся к начальной модельной функции и проверим более широкий диапазон для n, например в 2 и 500.

n=2

Solution:

[1. 1.]

Newton iteration = 6

Newton method time 0.048 seconds

n=500

Системы нелинейных уравнений

При решении задач моделирования поведения химических систем достаточно часто приходится решать системы уравнений, нелинейных по отношению к переменным. Системы n линейных уравнений с n неизвестными x 1 , x 2 , . xn в общем случае принято записывать следующим образом:

где F 1 , F 2 ,…, Fn – любые функции независимых переменных, в том числе и нелинейные относительно неизвестных.

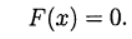

Как и в случае систем линейных уравнений, решением системы является такой вектор (или векторы) ( X * ) , который при подстановке обращает одновременно все уравнения системы в тождества.

Система уравнений может не иметь решений, иметь единственное решение, конечное или бесконечное количество решений. Вопрос о количестве решений должен решаться для каждой конкретной задачи отдельно.

Рассмотрим несколько простейших итерационных методов решения систем нелинейных уравнений, а именно, метод простой итерации, метод Зейделя и метод Ньютона.

Метод простой итерации

Для реализации этого метода решаемую систему уравнений необходимо путем алгебраических преобразований привести к следующему виду, выразив из каждого уравнения по одной переменной следующим образом:

Выбирая затем вектор начального приближения

,

подставляют его в преобразованную систему уравнений. Из первого уравнения получают новое приближение к первой переменной, из второго – второй и т. д. Полученное уточненное значение переменных снова подставляют в эти уравнения и т.д.Таким образом, на ( i+1 ) -м шаге итерационной процедуры имеем

Модификация Зейделя алгоритма простой итерации заключается в использовании уточненных значений переменных уже на текущем итерационном шаге. Так, для уточнения значений первой переменной используются только значения предыдущего шага, для второй переменной – значение x1 текущего шага, а остальных – от предыдущего и т.д.:

Математической основой метода является линеаризация функций F 1 , F 2 , Fn (левых частей уравнений, образующих систему) путем разложения в ряд Тейлора в окрестности точки начального приближения к решению и пренебрежением всеми членами ряда кроме линейных относительно приращений переменных.

Рассмотрим метод на примере системы двух уравнений с двумя неизвестными:

Линеаризуем функции F 1 , F 2 путем разложения в ряд Тейлора вблизи некоторой точки (начального приближения) и пренебрежения всеми членами ряда кроме линейных относительно приращений переменных.

Вспомним, что для функции одной переменной разложение в ряд Тейлора в окрестности некоторой точки x0 имеет следующий вид:

после пренебрежения всеми членами, кроме линейного:

Для функции нескольких переменных разложение проводится аналогично.

Выберем для поиска решения системы уравнений некоторое начальное приближение

Запишем для функции F1 2-х переменных линейную часть разложения в ряд Тейлора в окрестности выбранной точки

для второго уравнения, аналогично

Если значения переменных x 1 и x 2 являются решением, то оба уравнения системы должны обратиться в ноль, поэтому полученные разложения приравниваем нулю.

Для краткости записи введем следующие обозначения:

— приращение i -ой переменной

— значение первой частной производной функции Fj по переменной xi при значении переменных

– значение j -ой функции при соответствующих значениях переменных, то есть невязка j ‑го уравнения.

Получим систему линейных уравнений 2 x 2 относительно приращения переменных

Или, в матричной форме,

где матрица значений частных производных называется матрицей Якоби (или якобианом). Решение этой системы дает вектор поправок к начальному приближению.

Сложение его с вектором начального приближения дает новые значения переменных.

Итерационная процедура далее продолжается аналогично.

Таким образом, процедура решения выглядит следующим образом:

1. Выбирается начальное приближение, система приводится к нормальному виду, в аналитическом виде находятся частные производные левых частей уравнений системы по всем переменным.

2. Рассчитывается матрица Якоби значений частных производных в точке начального приближения

3. Решается система линейных уравнений относительно приращений переменных.

4. к вектору начального приближения прибавляется вектор приращений

5. проверяется условие сходимости и, если оно не достигнуто, то процедура повторяется с п. 2.

Метод легко обобщается на систему уравнений любой размерности.

Для функции F 1 n переменных линейная часть разложения в ряд Тейлора в окрестности точки

После разложения всех уравнений системы и используя введенные ранее обозначения, после преобразования получим систему линейных уравнений порядка n относительно приращения переменных Δ xi

Или, в матричной форме,

В сокращенном виде можно записать так — ( F’ )(Δ x ) = — ( F ) , где матрица значений частных производных – ( F’ ) – называется матрицей Якоби или якобианом системы уравнений.

Решение этой системы дает вектор поправок к начальному приближению. Сложение его с вектором начального приближения дает новые, уточненные значения переменных.

Частные производные, необходимые для расчета матрицы Якоби, можно рассчитать аналитически или же, если это невозможно или затруднительно, получать по формулам приближенного дифференцирования, например, как отношение приращения функции к приращению аргумента

где эпсилон – достаточно малое число.

Методы контроля сходимости итерационных методов

решения систем

Сходимость итерационного процесса решения системы нелинейных уравнений можно контролировать несколькими способами, например:

1. Норма (эвклидова или -максимум) вектора невязок

2. Эвклидова норма вектора относительных отклонений переменных

3. Норма-максимум вектора относительных отклонений

Применим метод Ньютона для решения системы уравнений

Матрица частных производных (в аналитическом виде)

Система линейных уравнений

Может быть решена аналитически или методом Крамера или методом обращения матрицы. Возьмем начальное приближение x = 0,15, y = 0,17

Первая итерация:

вектор значений функции

Рассчитанный вектор поправок

Новое приближение x = 0,15 + 0,028704 = 0,178704, y = 0,17 + 0,090926 = 0,260926

Вторая итерация:

Рассчитанный вектор поправок

Новое приближение x = 0,196656, y = 0,293359

Третья итерация:

Рассчитанный вектор поправок

Новое приближение x = 0,199867, y = 0,299739

Уже на 6-й итерации эвклидова норма вектора невязок составляет 2.8∙10 -13 , максимальное относительное изменение переменных составляет 1.6∙10 -12 и решение сходится к x = 0.2, y = 0.3 с абсолютной погрешностью менее 5∙10 -7 .

Метод простой итерации при этих же начальных условиях сходится с такой точностью на 33-м шаге, модификация Зейделя – на 31-м шаге.

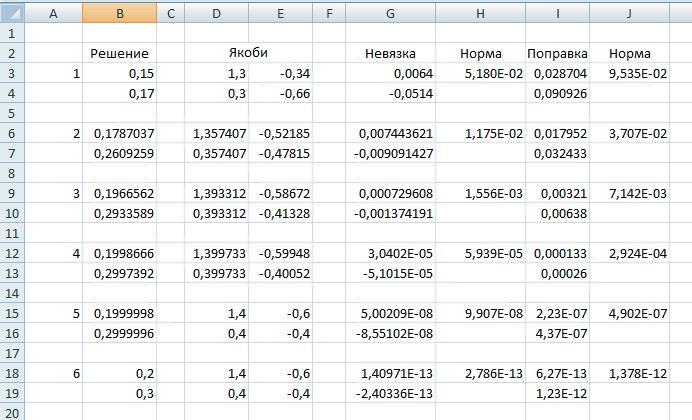

На рисунке ниже представлен пример организации вычислений при решении рассмотренной системы в программе MS Excel

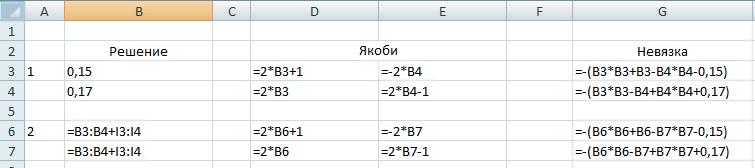

Пояснения: В ячейки В3 и В4 помещены начальные приближения к решению системы (значения х 0 и у 0 , соответственно). В диапазоне ячеек D3:E4 помещены формулы для вычисления матрицы Якоби, при условии что х находится в ячейке В3, а у — в ячейке В4 (формулы приведены на рисунке ниже). В ячейках G3:G4 рассчитывается значение вектора невязок с отрицательным знаком.

В ячейке Н3 вычисляется эвклидова норма вектора невязок. В ячейках I3:I4 — решается система линейных уравнений и вычисляется вектор поправок к решению. Для этого обращается матрица коэффициентов системы (матрица Якоби) и умножается на вектор-столбец свободных членов (отрицательный вектор невязок). Формула в этот диапазон ячеек вводится как формула массива. Рядом — в ячейке J3 — рассчитывается норма вектора поправок для контроля сходимости (см. формулы на рисунке ниже).

Полученные в ячейках I3:I4 значения поправок на втором итерационном цикле прибавляются к начальному приближению (в ячейках В6:В7) и далее вычисления повторяются аналогично первому циклу.

Набранные в строках 6 и 7 рабочего листа формулы могут копироваться до тех пор, пока не будет достигнута необходимая точность.

Задачи, сводящиеся к решению системы нелинейных уравнений

Примером задачи, в которой используется решение систем нелинейных уравнений, может служить аппроксимация таблично заданной функции математическими моделями, нелинейными по отношению к параметрам. Подробно она описывалась ранее.

Если аппроксимирующую функцию и определяющие ее параметры ai обозначить следующим образом

то условие прохождения графика функции через все таблично заданные точки можно записать в виде следующей системы:

Другой пример — поиск экстремума (минимума или максимума) функции нескольких переменных

Условием экстремума является одновременное равенство нулю всех частных производных функции. Таким образом, необходимо решить систему уравнений следующего вида, которая, в общем случае, будет нелинейной

http://habr.com/ru/post/419453/

http://physchem.chimfak.sfedu.ru/Source/NumMethods/Sys_non-lin_eq.html