Задача №1 Построение уравнения регрессии

Имеются следующие данные разных стран об индексе розничных цен на продукты питания (х) и об индексе промышленного производства (у).

| Индекс розничных цен на продукты питания (х) | Индекс промышленного производства (у) | |

|---|---|---|

| 1 | 100 | 70 |

| 2 | 105 | 79 |

| 3 | 108 | 85 |

| 4 | 113 | 84 |

| 5 | 118 | 85 |

| 6 | 118 | 85 |

| 7 | 110 | 96 |

| 8 | 115 | 99 |

| 9 | 119 | 100 |

| 10 | 118 | 98 |

| 11 | 120 | 99 |

| 12 | 124 | 102 |

| 13 | 129 | 105 |

| 14 | 132 | 112 |

Требуется:

1. Для характеристики зависимости у от х рассчитать параметры следующих функций:

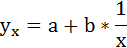

В) равносторонней гиперболы.

2. Для каждой модели рассчитать показатели: тесноты связи и среднюю ошибку аппроксимации.

3. Оценить статистическую значимость параметров регрессии и корреляции.

4. Выполнить прогноз значения индекса промышленного производства у при прогнозном значении индекса розничных цен на продукты питания х=138.

Решение:

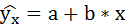

1. Для расчёта параметров линейной регрессии

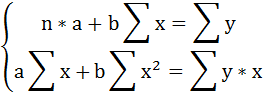

Решаем систему нормальных уравнений относительно a и b:

Построим таблицу расчётных данных, как показано в таблице 1.

Таблица 1 Расчетные данные для оценки линейной регрессии

| № п/п | х | у | ху | x 2 | y 2 |  |  |

|---|---|---|---|---|---|---|---|

| 1 | 100 | 70 | 7000 | 10000 | 4900 | 74,26340 | 0,060906 |

| 2 | 105 | 79 | 8295 | 11025 | 6241 | 79,92527 | 0,011712 |

| 3 | 108 | 85 | 9180 | 11664 | 7225 | 83,32238 | 0,019737 |

| 4 | 113 | 84 | 9492 | 12769 | 7056 | 88,98425 | 0,059336 |

| 5 | 118 | 85 | 10030 | 13924 | 7225 | 94,64611 | 0,113484 |

| 6 | 118 | 85 | 10030 | 13924 | 7225 | 94,64611 | 0,113484 |

| 7 | 110 | 96 | 10560 | 12100 | 9216 | 85,58713 | 0,108467 |

| 8 | 115 | 99 | 11385 | 13225 | 9801 | 91,24900 | 0,078293 |

| 9 | 119 | 100 | 11900 | 14161 | 10000 | 95,77849 | 0,042215 |

| 10 | 118 | 98 | 11564 | 13924 | 9604 | 94,64611 | 0,034223 |

| 11 | 120 | 99 | 11880 | 14400 | 9801 | 96,91086 | 0,021102 |

| 12 | 124 | 102 | 12648 | 15376 | 10404 | 101,4404 | 0,005487 |

| 13 | 129 | 105 | 13545 | 16641 | 11025 | 107,1022 | 0,020021 |

| 14 | 132 | 112 | 14784 | 17424 | 12544 | 110,4993 | 0,013399 |

| Итого: | 1629 | 1299 | 152293 | 190557 | 122267 | 1299,001 | 0,701866 |

| Среднее значение: | 116,3571 | 92,78571 | 10878,07 | 13611,21 | 8733,357 | х | х |

| 8,4988 | 11,1431 | х | х | х | х | х |

| 72,23 | 124,17 | х | х | х | х | х |

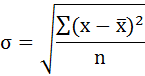

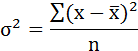

Среднее значение определим по формуле:

Cреднее квадратическое отклонение рассчитаем по формуле:

и занесём полученный результат в таблицу 1.

Возведя в квадрат полученное значение получим дисперсию:

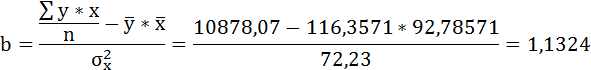

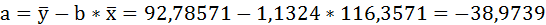

Параметры уравнения можно определить также и по формулам:

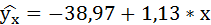

Таким образом, уравнение регрессии:

Следовательно, с увеличением индекса розничных цен на продукты питания на 1, индекс промышленного производства увеличивается в среднем на 1,13.

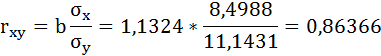

Рассчитаем линейный коэффициент парной корреляции:

Связь прямая, достаточно тесная.

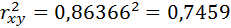

Определим коэффициент детерминации:

Вариация результата на 74,59% объясняется вариацией фактора х.

Подставляя в уравнение регрессии фактические значения х, определим теоретические (расчётные) значения

следовательно, параметры уравнения определены правильно.

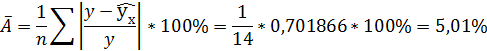

Рассчитаем среднюю ошибку аппроксимации – среднее отклонение расчётных значений от фактических:

В среднем расчётные значения отклоняются от фактических на 5,01%.

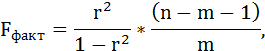

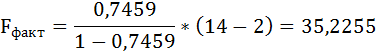

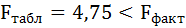

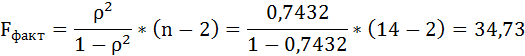

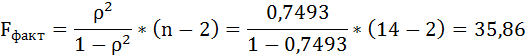

Оценку качества уравнения регрессии проведём с помощью F-теста.

F-тест состоит в проверке гипотезы Н0 о статистической незначимости уравнения регрессии и показателя тесноты связи. Для этого выполняется сравнение фактического Fфакт и критического (табличного) Fтабл значений F-критерия Фишера.

Fфакт определяется по формуле:

где n – число единиц совокупности;

m – число параметров при переменных х.

Таким образом, Н0 – гипотеза о случайной природе оцениваемых характеристик отклоняется и признаётся их статистическая значимость и надёжность.

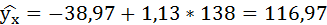

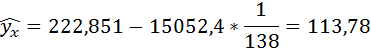

Полученные оценки уравнения регрессии позволяют использовать его для прогноза.

Если прогнозное значение индекса розничных цен на продукты питания х = 138, тогда прогнозное значение индекса промышленного производства составит:

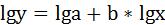

2. Степенная регрессия имеет вид:

Для определения параметров производят логарифмирование степенной функции:

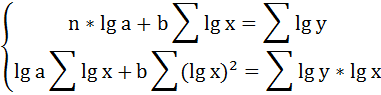

Для определения параметров логарифмической функции строят систему нормальных уравнений по способу наименьших квадратов:

Построим таблицу расчётных данных, как показано в таблице 2.

Таблица 2 Расчетные данные для оценки степенной регрессии

| №п/п | х | у | lg x | lg y | lg x*lg y | (lg x) 2 | (lg y) 2 |

|---|---|---|---|---|---|---|---|

| 1 | 100 | 70 | 2,000000 | 1,845098 | 3,690196 | 4,000000 | 3,404387 |

| 2 | 105 | 79 | 2,021189 | 1,897627 | 3,835464 | 4,085206 | 3,600989 |

| 3 | 108 | 85 | 2,033424 | 1,929419 | 3,923326 | 4,134812 | 3,722657 |

| 4 | 113 | 84 | 2,053078 | 1,924279 | 3,950696 | 4,215131 | 3,702851 |

| 5 | 118 | 85 | 2,071882 | 1,929419 | 3,997528 | 4,292695 | 3,722657 |

| 6 | 118 | 85 | 2,071882 | 1,929419 | 3,997528 | 4,292695 | 3,722657 |

| 7 | 110 | 96 | 2,041393 | 1,982271 | 4,046594 | 4,167284 | 3,929399 |

| 8 | 115 | 99 | 2,060698 | 1,995635 | 4,112401 | 4,246476 | 3,982560 |

| 9 | 119 | 100 | 2,075547 | 2,000000 | 4,151094 | 4,307895 | 4,000000 |

| 10 | 118 | 98 | 2,071882 | 1,991226 | 4,125585 | 4,292695 | 3,964981 |

| 11 | 120 | 99 | 2,079181 | 1,995635 | 4,149287 | 4,322995 | 3,982560 |

| 12 | 124 | 102 | 2,093422 | 2,008600 | 4,204847 | 4,382414 | 4,034475 |

| 13 | 129 | 105 | 2,110590 | 2,021189 | 4,265901 | 4,454589 | 4,085206 |

| 14 | 132 | 112 | 2,120574 | 2,049218 | 4,345518 | 4,496834 | 4,199295 |

| Итого | 1629 | 1299 | 28,90474 | 27,49904 | 56,79597 | 59,69172 | 54,05467 |

| Среднее значение | 116,3571 | 92,78571 | 2,064624 | 1,964217 | 4,056855 | 4,263694 | 3,861048 |

| 8,4988 | 11,1431 | 0,031945 | 0,053853 | х | х | х |

| 72,23 | 124,17 | 0,001021 | 0,0029 | х | х | х |

Продолжение таблицы 2 Расчетные данные для оценки степенной регрессии

| №п/п | х | у |  |  |  |  |

|---|---|---|---|---|---|---|

| 1 | 100 | 70 | 74,16448 | 17,34292 | 0,059493 | 519,1886 |

| 2 | 105 | 79 | 79,62057 | 0,385112 | 0,007855 | 190,0458 |

| 3 | 108 | 85 | 82,95180 | 4,195133 | 0,024096 | 60,61728 |

| 4 | 113 | 84 | 88,59768 | 21,13866 | 0,054734 | 77,1887 |

| 5 | 118 | 85 | 94,35840 | 87,57961 | 0,110099 | 60,61728 |

| 6 | 118 | 85 | 94,35840 | 87,57961 | 0,110099 | 60,61728 |

| 7 | 110 | 96 | 85,19619 | 116,7223 | 0,11254 | 10,33166 |

| 8 | 115 | 99 | 90,88834 | 65,79901 | 0,081936 | 38,6174 |

| 9 | 119 | 100 | 95,52408 | 20,03384 | 0,044759 | 52,04598 |

| 10 | 118 | 98 | 94,35840 | 13,26127 | 0,037159 | 27,18882 |

| 11 | 120 | 99 | 96,69423 | 5,316563 | 0,023291 | 38,6174 |

| 12 | 124 | 102 | 101,4191 | 0,337467 | 0,005695 | 84,90314 |

| 13 | 129 | 105 | 107,4232 | 5,872099 | 0,023078 | 149,1889 |

| 14 | 132 | 112 | 111,0772 | 0,85163 | 0,00824 | 369,1889 |

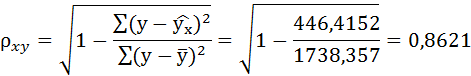

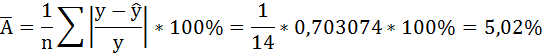

| Итого | 1629 | 1299 | 1296,632 | 446,4152 | 0,703074 | 1738,357 |

| Среднее значение | 116,3571 | 92,78571 | х | х | х | х |

| 8,4988 | 11,1431 | х | х | х | х |

| 72,23 | 124,17 | х | х | х | х |

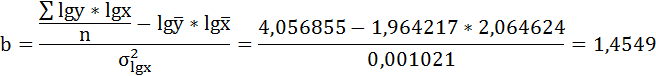

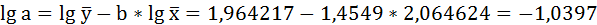

Решая систему нормальных уравнений, определяем параметры логарифмической функции.

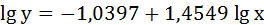

Получим линейное уравнение:

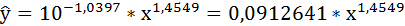

Выполнив его потенцирование, получим:

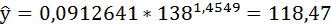

Подставляя в данное уравнение фактические значения х, получаем теоретические значения результата

Связь достаточно тесная.

В среднем расчётные значения отклоняются от фактических на 5,02%.

Таким образом, Н0 – гипотеза о случайной природе оцениваемых характеристик отклоняется и признаётся их статистическая значимость и надёжность.

Полученные оценки уравнения регрессии позволяют использовать его для прогноза. Если прогнозное значение индекса розничных цен на продукты питания х = 138, тогда прогнозное значение индекса промышленного производства составит:

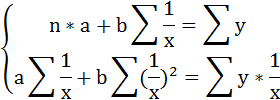

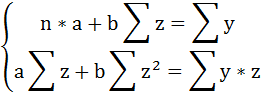

3. Уравнение равносторонней гиперболы

Для определения параметров этого уравнения используется система нормальных уравнений:

Произведем замену переменных

и получим следующую систему нормальных уравнений:

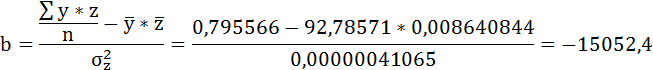

Решая систему нормальных уравнений, определяем параметры гиперболы.

Составим таблицу расчётных данных, как показано в таблице 3.

Таблица 3 Расчетные данные для оценки гиперболической зависимости

| №п/п | х | у | z | yz |  |  |

|---|---|---|---|---|---|---|

| 1 | 100 | 70 | 0,010000000 | 0,700000 | 0,0001000 | 4900 |

| 2 | 105 | 79 | 0,009523810 | 0,752381 | 0,0000907 | 6241 |

| 3 | 108 | 85 | 0,009259259 | 0,787037 | 0,0000857 | 7225 |

| 4 | 113 | 84 | 0,008849558 | 0,743363 | 0,0000783 | 7056 |

| 5 | 118 | 85 | 0,008474576 | 0,720339 | 0,0000718 | 7225 |

| 6 | 118 | 85 | 0,008474576 | 0,720339 | 0,0000718 | 7225 |

| 7 | 110 | 96 | 0,009090909 | 0,872727 | 0,0000826 | 9216 |

| 8 | 115 | 99 | 0,008695652 | 0,860870 | 0,0000756 | 9801 |

| 9 | 119 | 100 | 0,008403361 | 0,840336 | 0,0000706 | 10000 |

| 10 | 118 | 98 | 0,008474576 | 0,830508 | 0,0000718 | 9604 |

| 11 | 120 | 99 | 0,008333333 | 0,825000 | 0,0000694 | 9801 |

| 12 | 124 | 102 | 0,008064516 | 0,822581 | 0,0000650 | 10404 |

| 13 | 129 | 105 | 0,007751938 | 0,813953 | 0,0000601 | 11025 |

| 14 | 132 | 112 | 0,007575758 | 0,848485 | 0,0000574 | 12544 |

| Итого: | 1629 | 1299 | 0,120971823 | 11,13792 | 0,0010510 | 122267 |

| Среднее значение: | 116,3571 | 92,78571 | 0,008640844 | 0,795566 | 0,0000751 | 8733,357 |

| 8,4988 | 11,1431 | 0,000640820 | х | х | х |

| 72,23 | 124,17 | 0,000000411 | х | х | х |

Продолжение таблицы 3 Расчетные данные для оценки гиперболической зависимости

| №п/п | х | у |  |  |  |  |

|---|---|---|---|---|---|---|

| 1 | 100 | 70 | 72,3262 | 0,033231 | 5,411206 | 519,1886 |

| 2 | 105 | 79 | 79,49405 | 0,006254 | 0,244083 | 190,0458 |

| 3 | 108 | 85 | 83,47619 | 0,017927 | 2,322012 | 60,61728 |

| 4 | 113 | 84 | 89,64321 | 0,067181 | 31,84585 | 77,1887 |

| 5 | 118 | 85 | 95,28761 | 0,121031 | 105,8349 | 60,61728 |

| 6 | 118 | 85 | 95,28761 | 0,121031 | 105,8349 | 60,61728 |

| 7 | 110 | 96 | 86,01027 | 0,10406 | 99,79465 | 10,33166 |

| 8 | 115 | 99 | 91,95987 | 0,071112 | 49,56344 | 38,6174 |

| 9 | 119 | 100 | 96,35957 | 0,036404 | 13,25272 | 52,04598 |

| 10 | 118 | 98 | 95,28761 | 0,027677 | 7,357059 | 27,18882 |

| 11 | 120 | 99 | 97,41367 | 0,016024 | 2,516453 | 38,6174 |

| 12 | 124 | 102 | 101,46 | 0,005294 | 0,291565 | 84,90314 |

| 13 | 129 | 105 | 106,1651 | 0,011096 | 1,357478 | 149,1889 |

| 14 | 132 | 112 | 108,8171 | 0,028419 | 10,1311 | 369,1889 |

| Итого: | 1629 | 1299 | 1298,988 | 0,666742 | 435,7575 | 1738,357 |

| Среднее значение: | 116,3571 | 92,78571 | х | х | х | х |

| 8,4988 | 11,1431 | х | х | х | х |

| 72,23 | 124,17 | х | х | х | х |

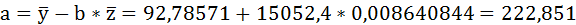

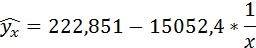

Значения параметров регрессии a и b составили:

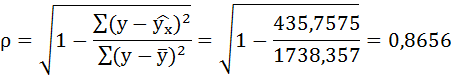

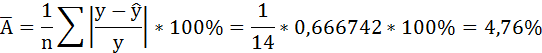

Связь достаточно тесная.

В среднем расчётные значения отклоняются от фактических на 4,76%.

Таким образом, Н0 – гипотеза о случайной природе оцениваемых характеристик отклоняется и признаётся их статистическая значимость и надёжность.

Полученные оценки уравнения регрессии позволяют использовать его для прогноза. Если прогнозное значение индекса розничных цен на продукты питания х = 138, тогда прогнозное значение индекса промышленного производства составит:

По уравнению равносторонней гиперболы получена наибольшая оценка тесноты связи по сравнению с линейной и степенной регрессиями. Средняя ошибка аппроксимации остаётся на допустимом уровне.

Решения задач: линейная регрессия и коэффициент корреляции

Парная линейная регрессия — это зависимость между одной переменной и средним значением другой переменной. Чаще всего модель записывается как $y=ax+b+e$, где $x$ — факторная переменная, $y$ — результативная (зависимая), $e$ — случайная компонента (остаток, отклонение).

В учебных задачах по математической статистике обычно используется следующий алгоритм для нахождения уравнения регрессии.

- Выбор модели (уравнения). Часто модель задана заранее (найти линейную регрессию) или для подбора используют графический метод: строят диаграмму рассеяния и анализируют ее форму.

- Вычисление коэффициентов (параметров) уравнения регрессии. Часто для этого используют метод наименьших квадратов.

- Проверка значимости коэффициента корреляции и параметров модели (также для них можно построить доверительные интервалы), оценка качества модели по критерию Фишера.

- Анализ остатков, вычисление стандартной ошибки регрессии, прогноз по модели (опционально).

Ниже вы найдете решения для парной регрессии (по рядам данных или корреляционной таблице, с разными дополнительными заданиями) и пару задач на определение и исследование коэффициента корреляции.

Примеры решений онлайн: линейная регрессия

Простая выборка

Пример 1. Имеются данные средней выработки на одного рабочего Y (тыс. руб.) и товарооборота X (тыс. руб.) в 20 магазинах за квартал. На основе указанных данных требуется:

1) определить зависимость (коэффициент корреляции) средней выработки на одного рабочего от товарооборота,

2) составить уравнение прямой регрессии этой зависимости.

Пример 2. С целью анализа взаимного влияния зарплаты и текучести рабочей силы на пяти однотипных фирмах с одинаковым числом работников проведены измерения уровня месячной зарплаты Х и числа уволившихся за год рабочих Y:

X 100 150 200 250 300

Y 60 35 20 20 15

Найти линейную регрессию Y на X, выборочный коэффициент корреляции.

Пример 3. Найти выборочные числовые характеристики и выборочное уравнение линейной регрессии $y_x=ax+b$. Построить прямую регрессии и изобразить на плоскости точки $(x,y)$ из таблицы. Вычислить остаточную дисперсию. Проверить адекватность линейной регрессионной модели по коэффициенту детерминации.

Пример 4. Вычислить коэффициенты уравнения регрессии. Определить выборочный коэффициент корреляции между плотностью древесины маньчжурского ясеня и его прочностью.

Решая задачу необходимо построить поле корреляции, по виду поля определить вид зависимости, написать общий вид уравнения регрессии Y на Х, определить коэффициенты уравнения регрессии и вычислить коэффициенты корреляции между двумя заданными величинами.

Пример 5. Компанию по прокату автомобилей интересует зависимость между пробегом автомобилей X и стоимостью ежемесячного технического обслуживания Y. Для выяснения характера этой связи было отобрано 15 автомобилей. Постройте график исходных данных и определите по нему характер зависимости. Рассчитайте выборочный коэффициент линейной корреляции Пирсона, проверьте его значимость при 0,05. Постройте уравнение регрессии и дайте интерпретацию полученных результатов.

Корреляционная таблица

Пример 6. Найти выборочное уравнение прямой регрессии Y на X по заданной корреляционной таблице

Пример 7. В таблице 2 приведены данные зависимости потребления Y (усл. ед.) от дохода X (усл. ед.) для некоторых домашних хозяйств.

1. В предположении, что между X и Y существует линейная зависимость, найдите точечные оценки коэффициентов линейной регрессии.

2. Найдите стандартное отклонение $s$ и коэффициент детерминации $R^2$.

3. В предположении нормальности случайной составляющей регрессионной модели проверьте гипотезу об отсутствии линейной зависимости между Y и X.

4. Каково ожидаемое потребление домашнего хозяйства с доходом $x_n=7$ усл. ед.? Найдите доверительный интервал для прогноза.

Дайте интерпретацию полученных результатов. Уровень значимости во всех случаях считать равным 0,05.

Пример 8. Распределение 100 новых видов тарифов на сотовую связь всех известных мобильных систем X (ден. ед.) и выручка от них Y (ден.ед.) приводится в таблице:

Необходимо:

1) Вычислить групповые средние и построить эмпирические линии регрессии;

2) Предполагая, что между переменными X и Y существует линейная корреляционная зависимость:

А) найти уравнения прямых регрессии, построить их графики на одном чертеже с эмпирическими линиями регрессии и дать экономическую интерпретацию полученных уравнений;

Б) вычислить коэффициент корреляции, на уровне значимости 0,05 оценить его значимость и сделать вывод о тесноте и направлении связи между переменными X и Y;

В) используя соответствующее уравнение регрессии, оценить среднюю выручку от мобильных систем с 20 новыми видами тарифов.

Коэффициент корреляции

Пример 9. На основании 18 наблюдений установлено, что на 64% вес X кондитерских изделий зависит от их объема Y. Можно ли на уровне значимости 0,05 утверждать, что между X и Y существует зависимость?

Пример 10. Исследование 27 семей по среднедушевому доходу (Х) и сбережениям (Y) дало результаты: $\overline

Решаем уравнение простой линейной регрессии

В статье рассматривается несколько способов определения математического уравнения линии простой (парной) регрессии.

Все рассматриваемые здесь способы решения уравнения основаны на методе наименьших квадратов. Обозначим способы следующим образом:

- Аналитическое решение

- Градиентный спуск

- Стохастический градиентный спуск

Для каждого из способов решения уравнения прямой, в статье приведены различные функции, которые в основном делятся на те, которые написаны без использования библиотеки NumPy и те, которые для проведения расчетов применяют NumPy. Считается, что умелое использование NumPy позволит сократить затраты на вычисления.

Весь код, приведенный в статье, написан на языке python 2.7 с использованием Jupyter Notebook. Исходный код и файл с данными выборки выложен на гитхабе

Статья в большей степени ориентирована как на начинающих, так и на тех, кто уже понемногу начал осваивать изучение весьма обширного раздела в искусственном интеллекте — машинного обучения.

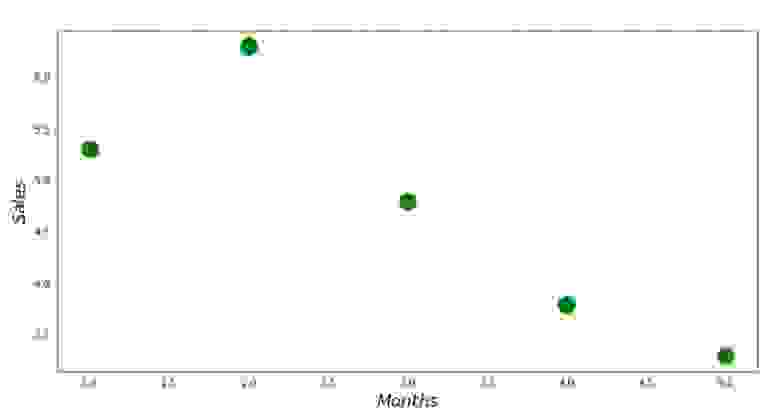

Для иллюстрации материала используем очень простой пример.

Условия примера

У нас есть пять значений, которые характеризуют зависимость Y от X (Таблица №1):

Таблица №1 «Условия примера»

Будем считать, что значения — это месяц года, а

— выручка в этом месяце. Другими словами, выручка зависит от месяца года, а

— единственный признак, от которого зависит выручка.

Пример так себе, как с точки зрения условной зависимости выручки от месяца года, так и с точки зрения количества значений — их очень мало. Однако такое упрощение позволит, что называется на пальцах, объяснить, не всегда с легкостью, усваиваемый новичками материал. А также простота чисел позволит без весомых трудозатрат, желающим, порешать пример на «бумаге».

Предположим, что приведенная в примере зависимость, может быть достаточно хорошо аппроксимирована математическим уравнением линии простой (парной) регрессии вида:

где — это месяц, в котором была получена выручка,

— выручка, соответствующая месяцу,

и

— коэффициенты регрессии оцененной линии.

Отметим, что коэффициент часто называют угловым коэффициентом или градиентом оцененной линии; представляет собой величину, на которую изменится

при изменении

.

Очевидно, что наша задача в примере — подобрать в уравнении такие коэффициенты и

, при которых отклонения наших расчетных значений выручки по месяцам от истинных ответов, т.е. значений, представленных в выборке, будут минимальны.

Метод наименьших квадратов

В соответствии с методом наименьших квадратов, отклонение стоит рассчитывать, возводя его в квадрат. Подобный прием позволяет избежать взаимного погашения отклонений, в том случае, если они имеют противоположные знаки. Например, если в одном случае, отклонение составляет +5 (плюс пять), а в другом -5 (минус пять), то сумма отклонений взаимно погасится и составит 0 (ноль). Можно и не возводить отклонение в квадрат, а воспользоваться свойством модуля и тогда у нас все отклонения будут положительными и будут накапливаться. Мы не будем останавливаться на этом моменте подробно, а просто обозначим, что для удобства расчетов, принято возводить отклонение в квадрат.

Вот так выглядит формула, с помощью которой мы определим наименьшую сумму квадратов отклонений (ошибки):

где — это функция аппроксимации истинных ответов (то есть посчитанная нами выручка),

— это истинные ответы (предоставленная в выборке выручка),

— это индекс выборки (номер месяца, в котором происходит определение отклонения)

Продифференцируем функцию, определим уравнения частных производных и будем готовы перейти к аналитическому решению. Но для начала проведем небольшой экскурс о том, что такое дифференцирование и вспомним геометрический смысл производной.

Дифференцирование

Дифференцированием называется операция по нахождению производной функции.

Для чего нужна производная? Производная функции характеризует скорость изменения функции и указывает нам ее направление. Если производная в заданной точке положительна, то функция возрастает, в обратном случае — функция убывает. И чем больше значение производной по модулю, тем выше скорость изменения значений функции, а также круче угол наклона графика функции.

Например, в условиях декартовой системы координат, значение производной в точке M(0,0) равное +25 означает, что в заданной точке, при смещении значения вправо на условную единицу, значение

возрастает на 25 условных единиц. На графике это выглядит, как достаточно крутой угол подъема значений

с заданной точки.

Другой пример. Значение производной равное -0,1 означает, что при смещении на одну условную единицу, значение

убывает всего лишь на 0,1 условную единицу. При этом, на графике функции, мы можем наблюдать едва заметный наклон вниз. Проводя аналогию с горой, то мы как будто очень медленно спускаемся по пологому склону с горы, в отличие от предыдущего примера, где нам приходилось брать очень крутые вершины:)

Таким образом, проведя дифференцирование функции по коэффициентам

и

, определим уравнения частных производных 1-го порядка. После определения уравнений, мы получим систему из двух уравнений, решив которую мы сможем подобрать такие значения коэффициентов

и

, при которых значения соответствующих производных в заданных точках изменяются на очень и очень малую величину, а в случае с аналитическим решением не изменяются вовсе. Другими словами, функция ошибки при найденных коэффициентах достигнет минимума, так как значения частных производных в этих точках будут равны нулю.

Итак, по правилам дифференцирования уравнение частной производной 1-го порядка по коэффициенту примет вид:

уравнение частной производной 1-го порядка по примет вид:

В итоге мы получили систему уравнений, которая имеет достаточно простое аналитическое решение:

\begin

\begin

na + b\sum\limits_

\\

\sum\limits_

\end

\end

Прежде чем решать уравнение, предварительно загрузим, проверим правильность загрузки и отформатируем данные.

Загрузка и форматирование данных

Необходимо отметить, что в связи с тем, что для аналитического решения, а в дальнейшем для градиентного и стохастического градиентного спуска, мы будем применять код в двух вариациях: с использованием библиотеки NumPy и без её использования, то нам потребуется соответствующее форматирование данных (см. код).

Визуализация

Теперь, после того, как мы, во-первых, загрузили данные, во-вторых, проверили правильность загрузки и наконец отформатировали данные, проведем первую визуализацию. Часто для этого используют метод pairplot библиотеки Seaborn. В нашем примере, ввиду ограниченности цифр нет смысла применять библиотеку Seaborn. Мы воспользуемся обычной библиотекой Matplotlib и посмотрим только на диаграмму рассеяния.

График №1 «Зависимость выручки от месяца года»

Аналитическое решение

Воспользуемся самыми обычными инструментами в python и решим систему уравнений:

\begin

\begin

na + b\sum\limits_

\\

\sum\limits_

\end

\end

По правилу Крамера найдем общий определитель, а также определители по и по

, после чего, разделив определитель по

на общий определитель — найдем коэффициент

, аналогично найдем коэффициент

.

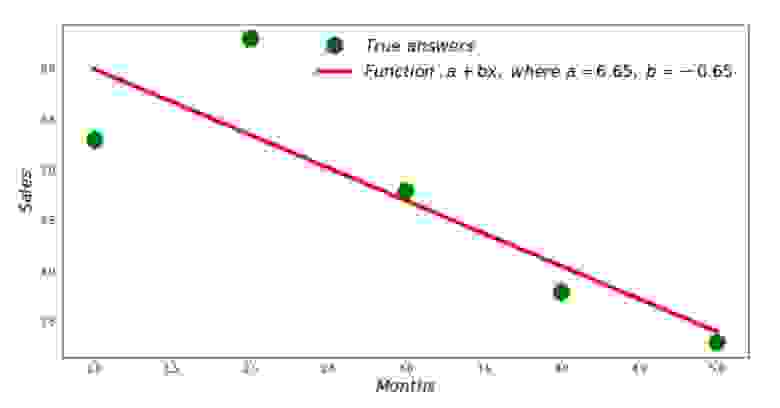

Вот, что у нас получилось:

Итак, значения коэффициентов найдены, сумма квадратов отклонений установлена. Нарисуем на гистограмме рассеяния прямую линию в соответствии с найденными коэффициентами.

График №2 «Правильные и расчетные ответы»

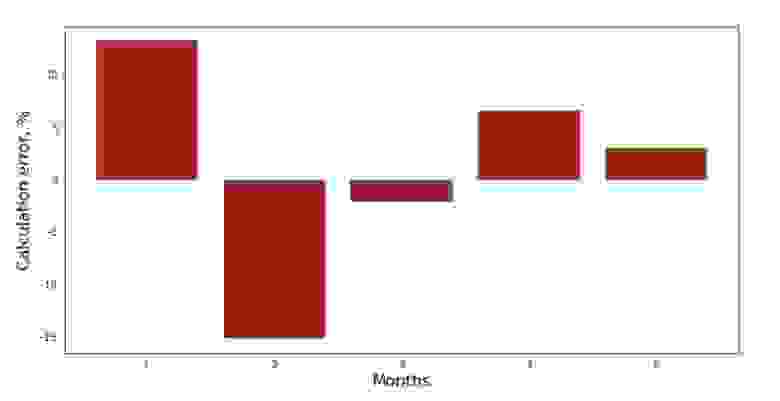

Можно посмотреть на график отклонений за каждый месяц. В нашем случае, какой-либо значимой практической ценности мы из него не вынесем, но удовлетворим любопытство в том, насколько хорошо, уравнение простой линейной регрессии характеризует зависимость выручки от месяца года.

График №3 «Отклонения, %»

Не идеально, но нашу задачу мы выполнили.

Напишем функцию, которая для определения коэффициентов и

использует библиотеку NumPy, точнее — напишем две функции: одну с использованием псевдообратной матрицы (не рекомендуется на практике, так как процесс вычислительно сложный и нестабильный), другую с использованием матричного уравнения.

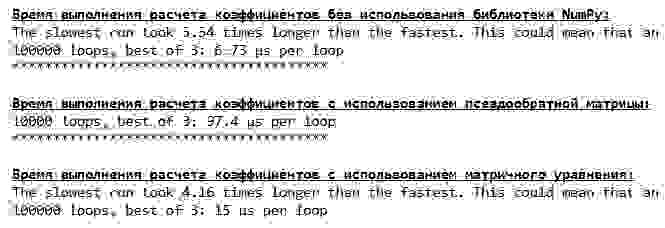

Сравним время, которое было затрачено на определение коэффициентов и

, в соответствии с 3-мя представленными способами.

На небольшом количестве данных, вперед выходит «самописная» функция, которая находит коэффициенты методом Крамера.

Теперь можно перейти к другим способам нахождения коэффициентов и

.

Градиентный спуск

Для начала определим, что такое градиент. По-простому, градиент — это отрезок, который указывает направление максимального роста функции. По аналогии с подъемом в гору, то куда смотрит градиент, там и есть самый крутой подъем к вершине горы. Развивая пример с горой, вспоминаем, что на самом деле нам нужен самый крутой спуск, чтобы как можно быстрее достичь низины, то есть минимума — места где функция не возрастает и не убывает. В этом месте производная будет равна нулю. Следовательно, нам нужен не градиент, а антиградиент. Для нахождения антиградиента нужно всего лишь умножить градиент на -1 (минус один).

Обратим внимание на то, что функция может иметь несколько минимумов, и опустившись в один из них по предложенному далее алгоритму, мы не сможем найти другой минимум, который возможно находится ниже найденного. Расслабимся, нам это не грозит! В нашем случае мы имеем дело с единственным минимумом, так как наша функция на графике представляет собой обычную параболу. А как мы все должны прекрасно знать из школьного курса математики — у параболы существует только один минимум.

После того, как мы выяснили для чего нам потребовался градиент, а также то, что градиент — это отрезок, то есть вектор с заданными координатами, которые как раз являются теми самыми коэффициентами и

мы можем реализовать градиентный спуск.

Перед запуском, предлагаю прочитать буквально несколько предложений об алгоритме спуска:

- Определяем псевдослучайным образом координаты коэффициентов

и

. В нашем примере, мы будем определять коэффициенты вблизи нуля. Это является распространённой практикой, однако для каждого случая может быть предусмотрена своя практика.

- От координаты

вычитаем значение частной производной 1-го порядка в точке

. Так, если производная будет положительная, то функция возрастает. Следовательно, отнимая значение производной, мы будем двигаться в обратную сторону роста, то есть в сторону спуска. Если производная отрицательна, значит функция в этой точке убывает и отнимая значение производной мы двигаемся в сторону спуска.

- Проводим аналогичную операцию с координатой

: вычитаем значение частной производной в точке

.

- Для того, чтобы не перескочить минимум и не улететь в далекий космос, необходимо установить размер шага в сторону спуска. В общем и целом, можно написать целую статью о том, как правильнее установить шаг и как его менять в процессе спуска, чтобы снизить затраты на вычисления. Но сейчас перед нами несколько иная задача, и мы научным методом «тыка» или как говорят в простонародье, эмпирическим путем, установим размер шага.

- После того, как мы из заданных координат

и

вычли значения производных, получаем новые координаты

и

. Делаем следующий шаг (вычитание), уже из рассчитанных координат. И так цикл запускается вновь и вновь, до тех пор, пока не будет достигнута требуемая сходимость.

Все! Теперь мы готовы отправиться на поиски самого глубокого ущелья Марианской впадины. Приступаем.

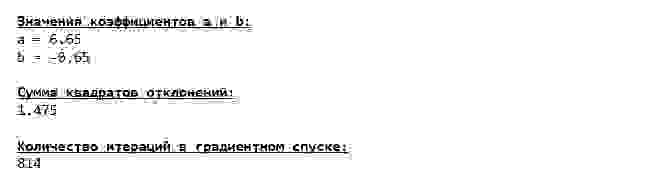

Мы погрузились на самое дно Марианской впадины и там обнаружили все те же значения коэффициентов и

, что собственно и следовало ожидать.

Совершим еще одно погружение, только на этот раз, начинкой нашего глубоководного аппарата будут иные технологии, а именно библиотека NumPy.

Значения коэффициентов и

неизменны.

Посмотрим на то, как изменялась ошибка при градиентном спуске, то есть как изменялась сумма квадратов отклонений с каждым шагом.

График №4 «Сумма квадратов отклонений при градиентном спуске»

На графике мы видим, что с каждым шагом ошибка уменьшается, а спустя какое-то количество итераций наблюдаем практически горизонтальную линию.

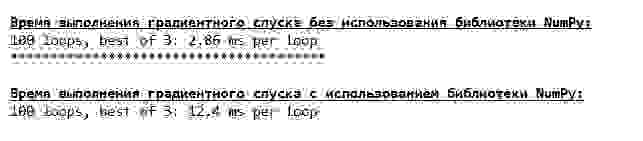

Напоследок оценим разницу во времени исполнения кода:

Возможно мы делаем что-то не то, но опять простая «самописная» функция, которая не использует библиотеку NumPy опережает по времени выполнения расчетов функцию, использующую библиотеку NumPy.

Но мы не стоим на месте, а двигаемся в сторону изучения еще одного увлекательного способа решения уравнения простой линейной регрессии. Встречайте!

Стохастический градиентный спуск

Для того, чтобы быстрее понять принцип работы стохастического градиентного спуска, лучше определить его отличия от обычного градиентного спуска. Мы, в случае с градиентным спуском, в уравнениях производных от и

использовали суммы значений всех признаков и истинных ответов, имеющихся в выборке (то есть суммы всех

и

). В стохастическом градиентном спуске мы не будем использовать все значения, имеющиеся в выборке, а вместо этого, псевдослучайным образом выберем так называемый индекс выборки и используем его значения.

Например, если индекс определился за номером 3 (три), то мы берем значения и

, далее подставляем значения в уравнения производных и определяем новые координаты. Затем, определив координаты, мы опять псевдослучайным образом определяем индекс выборки, подставляем значения, соответствующие индексу в уравнения частных производных, по новому определяем координаты

и

и т.д. до

позеленения сходимости. На первый взгляд, может показаться, как это вообще может работать, однако работает. Правда стоит отметить, что не с каждым шагом уменьшается ошибка, но тенденция безусловно имеется.

Каковы преимущества стохастического градиентного спуска перед обычным? В случае, если у нас размер выборки очень велик и измеряется десятками тысяч значений, то значительно проще обработать, допустим случайную тысячу из них, нежели всю выборку. Вот в этом случае и запускается стохастический градиентный спуск. В нашем случае мы конечно же большой разницы не заметим.

Смотрим внимательно на коэффициенты и ловим себя на вопросе «Как же так?». У нас получились другие значения коэффициентов и

. Может быть стохастический градиентный спуск нашел более оптимальные параметры уравнения? Увы, нет. Достаточно посмотреть на сумму квадратов отклонений и увидеть, что при новых значениях коэффициентов, ошибка больше. Не спешим отчаиваться. Построим график изменения ошибки.

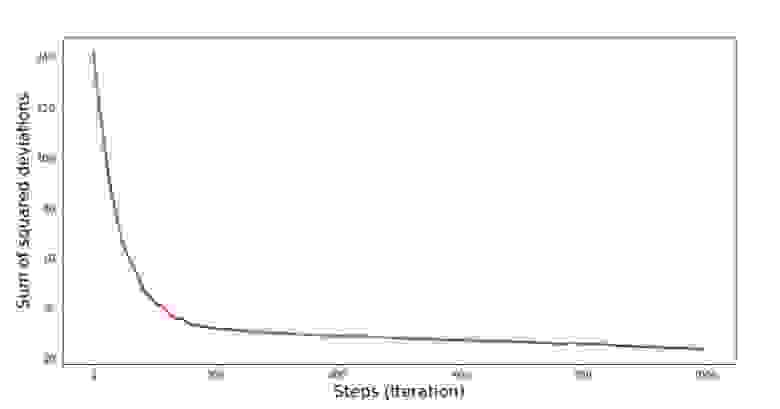

График №5 «Сумма квадратов отклонений при стохастическом градиентном спуске»

Посмотрев на график, все становится на свои места и сейчас мы все исправим.

Итак, что же произошло? Произошло следующее. Когда мы выбираем случайным образом месяц, то именно для выбранного месяца наш алгоритм стремится уменьшить ошибку в расчете выручки. Затем выбираем другой месяц и повторяем расчет, но ошибку уменьшаем уже для второго выбранного месяца. А теперь вспомним, что у нас первые два месяца существенно отклоняются от линии уравнения простой линейной регрессии. Это значит, что когда выбирается любой из этих двух месяцев, то уменьшая ошибку каждого из них, наш алгоритм серьезно увеличивает ошибку по всей выборке. Так что же делать? Ответ простой: надо уменьшить шаг спуска. Ведь уменьшив шаг спуска, ошибка так же перестанет «скакать» то вверх, то вниз. Вернее, ошибка «скакать» не перестанет, но будет это делать не так прытко:) Проверим.

График №6 «Сумма квадратов отклонений при стохастическом градиентном спуске (80 тыс. шагов)»

Значения коэффициентов улучшились, но все равно не идеальны. Гипотетически это можно поправить таким образом. Выбираем, например, на последних 1000 итерациях значения коэффициентов, с которыми была допущена минимальная ошибка. Правда нам для этого придется записывать еще и сами значения коэффициентов. Мы не будем этого делать, а лучше обратим внимание на график. Он выглядит гладким, и ошибка как будто уменьшается равномерно. На самом деле это не так. Посмотрим на первые 1000 итераций и сравним их с последними.

График №7 «Сумма квадратов отклонений SGD (первые 1000 шагов)»

График №8 «Сумма квадратов отклонений SGD (последние 1000 шагов)»

В самом начале спуска мы наблюдаем достаточно равномерное и крутое уменьшение ошибки. На последних итерациях мы видим, что ошибка ходит вокруг да около значения в 1,475 и в некоторые моменты даже равняется этому оптимальному значению, но потом все равно уходит ввысь… Повторюсь, можно записывать значения коэффициентов и

, а потом выбрать те, при которых ошибка минимальна. Однако у нас возникла проблема посерьезнее: нам пришлось сделать 80 тыс. шагов (см. код), чтобы получить значения, близкие к оптимальным. А это, уже противоречит идее об экономии времени вычислений при стохастическом градиентном спуске относительно градиентного. Что можно поправить и улучшить? Не трудно заметить, что на первых итерациях мы уверенно идем вниз и, следовательно, нам стоит оставить большой шаг на первых итерациях и по мере продвижения вперед шаг уменьшать. Мы не будем этого делать в этой статье — она и так уже затянулась. Желающие могут и сами подумать, как это сделать, это не сложно 🙂

Теперь выполним стохастический градиентный спуск, используя библиотеку NumPy (и не будем спотыкаться о камни, которые мы выявили раннее)

Значения получились почти такими же, как и при спуске без использования NumPy. Впрочем, это логично.

Узнаем сколько же времени занимали у нас стохастические градиентные спуски.

Чем дальше в лес, тем темнее тучи: опять «самописная» формула показывает лучший результат. Все это наводит на мысли о том, что должны существовать еще более тонкие способы использования библиотеки NumPy, которые действительно ускоряют операции вычислений. В этой статье мы о них уже не узнаем. Будет о чем подумать на досуге:)

Резюмируем

Перед тем как резюмировать, хотелось бы ответить на вопрос, который скорее всего, возник у нашего дорогого читателя. Для чего, собственно, такие «мучения» со спусками, зачем нам ходить по горе вверх и вниз (преимущественно вниз), чтобы найти заветную низину, если в наших руках такой мощный и простой прибор, в виде аналитического решения, который мгновенно телепортирует нас в нужное место?

Ответ на этот вопрос лежит на поверхности. Сейчас мы разбирали очень простой пример, в котором истинный ответ зависит от одного признака

. В жизни такое встретишь не часто, поэтому представим, что у нас признаков 2, 30, 50 или более. Добавим к этому тысячи, а то и десятки тысяч значений для каждого признака. В этом случае аналитическое решение может не выдержать испытания и дать сбой. В свою очередь градиентный спуск и его вариации будут медленно, но верно приближать нас к цели — минимуму функции. А на счет скорости не волнуйтесь — мы наверняка еще разберем способы, которые позволят нам задавать и регулировать длину шага (то есть скорость).

А теперь собственно краткое резюме.

Во-первых, надеюсь, что изложенный в статье материал, поможет начинающим «дата сайнтистам» в понимании того, как решать уравнения простой (и не только) линейной регрессии.

Во-вторых, мы рассмотрели несколько способов решения уравнения. Теперь, в зависимости от ситуации, мы можем выбрать тот, который лучше всего подходит для решения поставленной задачи.

В-третьих, мы увидели силу дополнительных настроек, а именно длины шага градиентного спуска. Этим параметром нельзя пренебрегать. Как было подмечено выше, с целью сокращения затрат на проведение вычислений, длину шага стоит изменять по ходу спуска.

В-четвертых, в нашем случае, «самописные» функции показали лучший временной результат вычислений. Вероятно, это связано с не самым профессиональным применением возможностей библиотеки NumPy. Но как бы то ни было, вывод напрашивается следующий. С одной стороны, иногда стоит подвергать сомнению устоявшиеся мнения, а с другой — не всегда стоит все усложнять — наоборот иногда эффективнее оказывается более простой способ решения задачи. А так как цель у нас была разобрать три подхода в решении уравнения простой линейной регрессии, то использование «самописных» функций нам вполне хватило.

Предыдущая работа автора — «Исследуем утверждение центральной предельной теоремы с помощью экспоненциального распределения»

Следующая работа автора — «Приводим уравнение линейной регрессии в матричный вид»

http://www.matburo.ru/ex_ms.php?p1=mslr

http://habr.com/ru/post/474602/